D-link Gigabit-Ethernet-Switches BROCHURE

SONDERDRUCK

I

n vielen Ethernet-basierten Unternehmens-

netzen sorgen Lastspitzen immer wieder dafür, dass es im Netz eng wird, und dann kommt

es je nach Aus- und Überlastung zu teils erheblichen Datenverlusten. Aber auch andere übertragungstechnische Parameter, wie Latency oder

Jitter, können – wenn sie gewisse Toleranzwerte

überschreiten, weil beispielsweise das Netzwerk

und seine Komponenten überfordert sind – zu

Störungen einzelner Services oder auch der gesamten Kommunikation führen. Im Zeitalter konvergenter Netze, die Echtzeit-

applikationen wie Voice- und Video-over-IP

aber auch Produktionsteuerungsdaten in das

klassische Datennetz integrieren, führen Datenverluste und andere Störungen in der Praxis zu

empfindlichen Kommunikationsstö-

rungen und Produktionsausfällen.

So haben in realen Projekten

schon mangelhaft priorisieren-

de Switches ganze Call-Center

außer Betrieb gesetzt.

Auswirkungen von

Datenverlusten

Bei klassischen Dateitransfers arbeitet

das System mit möglichst großen Datenrahmen. Bei Echtzeit-Applikationen teilt sich

das Feld. Video-Übertragungen nutzen ähnlich den Dateitransfers relativ große Datenrahmen. Voice-over-IP bewegt sich dagegen

im Mittelfeld.

Kritische und wichtige Daten

müssen auch in hochperformanten konvergenten Netzen

bevorzugt behandelt werden,

dafür sorgen Gigabit-EthernetLAN-Switches mit Datenpriorisierung. Wie schnell und intelligent solche Systeme sind,

mussten sechs Exemplare in

unseren Real-World Labs beweisen.

Reportcard / interaktiv unter www.networkcomputing.de

Policy-based Switching

A>=4,3; B>=3,5; C>=2.5; D>=1,5; E<1,5;

Die Bewertungen A bis Cbeinhalten in ihren Bereichen +

oder -;

Gesamtergebnisse und gewichtete Ergebnisse basieren auf

einer Skala von 0 bis 5.

D-Link HP ProCurve Extreme Networks Allied Telesyn Dell SMC

Feature Gewichtung DXS-3350SR Switch 5308x Summit 400-48T AT-9924T PowerConnect 6024 TigerSwitch 8648T

Strict-Priority-Switching Layer-2 Burst-Size 1 12,5 % 555555

Strict-Priority-Switching Layer-2 Burst-Size 100 12,5 % 332212

Bandbreitenmanagement Layer-2 Burst-Size 1 12,5 % 554442

Bandbreitenmanagement Layer-2 Burst-Size 100 12,5 % 554442

Strict-Priority-Switching Layer-3 Burst-Size 1 12,5 % 5 3 5555

Strict-Priority-Switching Layer-3 Burst-Size 100 12,5 % 331212

Bandbreitenmanagement Layer-3 Burst-Size 1 12,5 % 5 4 5 442

Bandbreitenmanagement Layer-3 Burst-Size 100 12,5 % 5 4 5 442

Gesamtergebnis 100 % 4,50 4,00 3,88 3,75 3,50 2,75

A- B+ B B- B- C

ZurReport-Card-Wertung: Um die Flut der Messergebnisse in eine Report-Card verdichten zu können, mussten wir einen Algorithmus definieren, der eine in Bezug auf eine generelle, anwendungsunabhängige Echtzeitfähigkeit aussagefähige,

relevante und trennscharfe Ergebnisbewertung ermöglicht. Bewertethaben wir die Differenz zwischen den zu erreichenden Sollwerten und den gemessenen Testergebnissen. Hierzu haben wir in den jeweiligen Disziplinen den jeweiligen Mittelwert

der Abweichungen errechnet und nach folgendem Schlüssel bewertet: Abweichung vom Sollwert </= 5% = 5, >5% = 4, >10% = 3, >20% = 2 und >30% = 1.

Gigabit-Ethernet-Switches

Schnell und

intelligent im Netz

Messungen mit Ethernet-LAN-Phones der ersten

Generation in unseren Real-World Labs haben

beispielsweise ergeben, dass diese Voice-over-IPLösung die Sprache mit konstant großen Rahmen

von 534 Byte überträgt. Aktuelle Lösungen überlassen es dem IT-Verantwortlichen selbst festzulegen, mit welchen Frame-Größen die Systeme

arbeiten sollen. Dabei sollte der IT-Verantwortliche berücksichtigen, dass der PaketierungsDelay mit kleiner werdenden Datenrahmen

kleiner wird. Dagegen wächst der Overhead, der

zu Lasten der Nutzdatenperformance geht, je

kleiner die verwendeten Pakete sind. Generell

kann man bei der IP-Sprachübertragung davon

ausgehen, dass mittelgroße Frames verwendet

werden. Und auch die meisten Web-Anwendungen nutzen mittelgroße Datenrahmen. Kurze Frames von 64 Byte sind dagegen beispielsweise bei

den TCP-Bestätigungspaketen oder interaktiven

Anwendungen wie Terminalsitzungen zu messen.

Für eine realitätsnahe und aussagefähige

Auswertung der Messergebnisse ist es darüber

hinaus entscheidend zu wissen, welche Framegrößen in welchen Verteilungen in realen Netzwerken vorkommen. Die Analyse der Verteilung

der Framegrößen, die für das MCI-Backbone

dokumentiert sind, sowie die Ergebnisse der

Analyse typischer Business-DSL-Links haben ergeben, dass rund 50 Prozent aller Datenrahmen

in realen Netzwerken 64 Byte groß sind. Die übrigen rund 50 Prozent der zu transportierenden

Datenrahmen streuen über alle Rahmengrößen

von 128 bis 1518 Byte.

Für die Übertragung von Real-Time-Applikationen ist zunächst das Datenverlustverhalten

von entscheidender Bedeutung. Für Voice-overIP gilt beispielsweise: Ab 5 Prozent Verlust ist je

nach Codec mit deutlicher Verschlechterung der

Übertragungsqualität zu rechnen, 10 Prozent

führen zu einer massiven Beeinträchtigung, ab

20 Prozent Datenverlust ist beispielsweise die

Te lefonie definitiv nicht mehr möglich. So verringert sich der R-Wert für die Sprachqualität

gemäß E-Modell nach ITU G.107 schon bei 10

Prozent Datenverlust um je nach Codec 25 bis

weit über 40 Punkte, also Werte, die massive

Probleme im Telefoniebereich sehr wahrscheinlich machen. Auf Grund ihrer Bedeutung für die

Übertragungsqualität haben wir daher das Datenrahmenverlustverhalten als primäres K.O.Kriterium für unseren Test definiert. Die Parameter Latency und Jitter sind dann für die genauere Diagnose und weitere Analyse im Einzelfall wichtig. Sind jedoch die Datenverlustraten

von Hause aus schon zu hoch, können gute

We rte für Latency und Jitter die Sprachqualität

auch nicht mehr retten. Dafür, dass es zu sol-

chen massiven Datenverlusten im Ethernet-LAN

erst gar nicht kommt, sollen entsprechend gut

funktionierende Priorisierungsmechanismen

sorgen. Bei entsprechender Überlast im Netz

sind Datenverluste ganz normal, jedoch sollen

sie durch die Priorisierungsmechanismen in der

Regel auf nicht echtzeitfähige Applikationen

verlagert werden. Arbeitet diese Priorisierung

nicht ausreichend, kommt es auch im Bereich

der höher priorisierten Daten zu unerwünschten Verlusten.

Qualitätssicherungsmechanismen

Um solchen Problemen vorzubeugen rüsten die

Ethernet-Hersteller ihre Switches mit einer zusätzlichen Funktionalität aus, die es ermöglichen

soll, bestimmten Applikationen die Vorfahrt im

Netzwerk einzuräumen, wenn es einmal eng

wird.Diese Priorisierungs-Mechanismen wer-

den allgemein als Class-of-Service oder – verfälschend in Anlehnung an ATM – als Quality-ofService bezeichnet. Standardisiert ist eine achtstufige Priorisierung auf Layer-2 nach IEEE

802.1p/Q und auf Layer-3 nach RFC

1349/2474/2475. Die jeweils zugeordnete Priorisierung lesen die Systeme aus den Headern der

Datenpakete aus.

Wie Switches die Datenpakete dann gemäß

ihrer Priorität behandeln, hängt von den jeweils

implementierten Queuing-Mechanismen ab. So

besteht beispielsweise die Möglichkeit, bestimmten Daten absolute Vorfahrt einzuräumen

oder auch für niedrigere Prioritäten Mindestdurchsatzraten zu garantieren. Eine gute

Queuing- oder Scheduling-Strategie sollte folgende Voraussetzungen erfüllen:

Sie muss die faire Verteilung der Bandbreite

auf die verschiedenen Serviceklassen unterstützen. Dabei sollte auch die Bandbreite für besondere Dienste berücksichtigt werden, so dass es zu

bestimmten Gewichtungen bei der Fairness

kommen kann.

Sie bietet Schutz zwischen den verschiedenen

Serviceklassen am Ausgangsport, so dass eine

Serviceklasse mit geringer Priorität nicht die

anderen Serviceklassen anderer Queues

beeinflussen kann.

We nn ein Dienst nicht die gesamte Bandbreite

verwendet, die für ihn reserviert ist, dann sollte

diese Überkapazität auch anderen Diensten zur

Ve rfügung stehen, bis der eigentliche Dienst diese Kapazitäten wieder benötigt. Alternativ soll die

Bandbreite für diesen Dienst absolut begrenzt

werden.

Ein schneller Algorithmus, der hardwaremäßig

implementiert werden kann, muss für diese Strategie existieren. Nur dann kann diese Strategie

auch auf Switches eingesetzt werden, die mit hoher Geschwindigkeit arbeiten. Algorithmen, die

nur softwareseitig implementiert werden können,

sind in der Regel ungeeignet, da man die Priorisierung bei hoher Last braucht und gerade dann

reicht die Performance der Softwarelösung in der

Regel nicht aus.

Eine intelligente Ausnutzung der in einem

konvergenten Netzwerk vorhandenen Bandbreiten und die Garantie für angemessene ServiceQualitäten der einzelnen Anwendungen setzt eine durchgängige Switching-Policy voraus, die

nicht nur blind bestimmten Daten die Vorfahrt

anderen gegenüber einräumt, sondern ein sinnvolles Bandbreitenmanagement für das gesamte

Netzwerk realisiert.

So ist es möglich, bei auftretenden Überlasten die Störungen im Betrieb gering und lokal

begrenzt zu halten. Aus diesem Grund haben

wir für unseren Real-World-Labs-Vergleichstest

Switches gefordert, die CoS-Queuing-Mechanismen sowie Bandbreitenmanagement unterstützen und damit erlauben, nicht nur bestimmten

Applikationen Vorfahrt anderen gegenüber einzuräumen, sondern auch durch die Einräumung

von Mindestbandbreiten die Service-Qualität

niedriger Prioritäten und somit das Funktionieren der entsprechenden Applikationen zu garantieren und dafür zu sorgen, dass Dienste nicht

mehr senden als vorgesehen.

Die Hersteller von Switches verwenden oft

eigene Namen für die CoS-Queuing-Strategien

oder ändern die eigentliche Strategie nach ihren

Vo rstellungen ab. Oft werden auch verschiedene

Strategien miteinander kombiniert, um die Ergebnisse zu verbessern. Die ursprünglichen

Queuing-Strategien sind:

First-In First-Out (FIFO),

Strict- und Rate-Controlled-Priority-Queuing (PQ),

Fair-Queuing (FQ),

We ighted-Fair-Queuing (WFQ),

We ighted-Round-Robin-Queuing (WRR),

auch

als Class-Based-Queuing (CBQ) bezeich-

net und

Deficit-Weighted-Round-Robin-Queuing

(DWRR).

Info

Gigabit-Ethernet-Switches

Allied Telesyn AT-9924T

Dell PowerConnect 6024

D-Link DXS-3350SR

Extreme Networks Summit 400-48T

HP ProCurve Switch 5308x

SMC TigerSwitch 8648T

Das Testfeld

Wie diese Verfahren im einzelnen arbeiten,

haben wir in einem separaten Grundlagenartikel in diesem Heft ab Seite 52 dargestellt.

Das Real-World-Labs-Testszenario

Wir wollten wissen, wie gut Queuing-Mechanismen heute in aktuellen LAN-Switches arbeiten

und ob es mit ihnen möglich ist, die gewünschte Policy zu realisieren. Aus diesem Grund haben wir sechs Class-of-Service-fähige LANSwitches einer umfangreichen Testprozedur unterzogen. Um unseren Test wie gewohnt im Vorfeld sauber zu strukturieren, haben wir zur Definition unserer Test-Spezifikation, die wir an alle einschlägigen Hersteller gesandt haben, wieder auf unser Modellunternehmen HighFair zurückgegriffen.

Das Modellunternehmen HighFair möchte

neben den klassischen Datenapplikationen und

Vo ice-over-IP weitere Real-Time-Applikationen

in ihr Unternehmensnetz integrieren. Ein geeigneter Vergleichstest sollte evaluieren, welche

Switches für diese Aufgaben auch unter entsprechender Last geeignet sind. Dabei sollten verschiedene CoS-Queuing-Mechanismen, wie

Strict-Priority-Queuing, Weighted-FairQueuing oder Weighted-Round-Robin, auf ihre

Eignung für das geplante Szenario untersucht

werden.

Folgende Dienste sollen im LAN integriert

werden:

Videokonferenzen (Video-over-IP, bidirektio-

nal, unicast),

Videodistribution (Multicast-Betrieb),

Vo ice-over-IP (Call-Center),

SAP-Anwendungsdaten sowie

übrige Datenanwendungen und Updates.

Um die möglichst absolute Störungsfreiheit

der Kommunikations- und Arbeitsprozesse im

Unternehmen zu garantieren, ist eine vierstufige

Daten-Priorisierung sowie eine intelligente

Queuing-Policy erforderlich. Gefordert ist für

die LAN-Switches neben der Datenpriorisierung

ein intelligentes Bandbreitenmanagement, das

es ermöglicht, von vorneherein eine Überlastung des Backbones zu vermeiden. Daraus ergaben sich folgende Anforderungen an die Teststellungen:

Layer-3-Gigabit-Ethernet-Switch,

mindestens 20 Gigabit-Ethernet-Kupfer-Ports

(RJ45-Stecker),

Datenpriorisierung nach IEEE 802.1p/Q auf

Layer-2,

Diffserv-Datenpriorisierung nach RFC 2474

oder

Ty pe-of-Service-Datenpriorisierung nach

RFC 791 und/oder 1349 auf Layer-3,

mindestens zwei CoS-Queuing-Mechanismen, wie Strict-Prioriry-Queuing, WeightedFair-Queuing oder Weighted-Round-Robin, die

softwareseitig konfiguriert werden können, sowie

Multicast-Funktionalität (IGMP-Snooping).

Als Testverfahren haben wir Messungen

nach RFC 2544 (Many-to-One) festgelegt, die

die Parameter Performance, Packet-Loss, Latency und Jitter ermitteln. Analysiert wird dann das

unterschiedliche Verhalten der Systeme in den

verschiedenen CoS-Queuing-Modi.

Unsere Testspezifikation haben wir an die

einschlägigen Hersteller geschickt und diese eingeladen, an unserem Vergleichstest in unseren

Real-World Labs an der FH Stralsund teilzunehmen. Auf den Herbstmessen Systems und Exponet haben wir dann den einschlägigen Herstellern unser Testprojekt erläutert. Neben Allied

Te lesyn, Dell, D-Link, Extreme Networks,

Hewlett-Packard und SMC waren auch Cisco,

Huawei und Nortel an einer Teilnahme interessiert. Als dann nach fast dreimonatiger Vorlaufphase unsere Testtermine anstanden, sah sich

Nortel nicht in der Lage, eine Teststellung zur

Ve rfügung zu stellen. Und auch Cisco hat wegen

»mangelnder Ressourcen« ihre Teilnahme abgesagt. Der chinesische Hersteller Huawei,der sich

gerade anschickt den europäischen Markt zu erobern, sah sich auch nicht in der Lage, unseren

Test zu unterstützen. Begründung: Auf Grund

des Chinesischen Neujahrfestes ist eine ausreichende Unterstützung der Tests momentan leider nicht gewährleistet, da zeitgleich so viele

Kundenanfragen und Tests durchgeführt werden müssen. Das Feld der Gigabit-EthernetSwitches bildeten schließlich Allied Telesyns

»AT-9924T«, Dells »PowerConnect 6024«, DLinks »DXS-3350SR«, Extreme Networks »Summit 400-48T«, HPs »ProCurve Switch 5308x«

und SMCs »TigerSwitch 8648T«. Im vorliegenden Artikel stellen wir die Messergebnisse mit

Strict-Priority-Queuing und mit Bandbreitenmanagement dar. In einer der nächsten Ausga-

ben von Network Computing berichten wir

dann, wie sich die Systeme in Bezug auf Multicast-Funktionalität und Stray-Frames verhalten

haben.

Die Gigabit-Ethernet-Switches im Test

Messtechnisch sind die einzelnen CoS-QueuingVe rfahren zum Teil schlecht auseinander zu halten, da sie unter entsprechenden Lasten zu einem ähnlichen Verhalten der Systeme führen.

Dieser Fakt ist aber auch nicht weiter problematisch, da für einen möglichst störungsfreien

Netzwerkbetrieb das konkrete Switching-Verhalten der Systeme und nicht die dahinter stehenden Mechanismen und Theorien entscheidend sind. Konkret haben wir zwei Policies isoliert und messtechnisch untersucht. Zunächst

sollten die Switches eine Strict-Priority-Policy

umsetzen. Hier kam es vor allem darauf an, dass

die Daten der höchsten Priorität unter allen

Umständen weitergeleitet werden sollten. Als

zweites Testszenario haben wir dann mit Bandbreitenmanagement gearbeitet. Hier sollten die

Systeme den Datenströmen aller vier Prioritäten

Maximalbandbreiten garantieren, um einem

Zusammenbruch der Anwendungen niedrigerer

Prioritäten bei Überlast vorzubeugen.

Aus den Ergebnissen von PerformanceMessungen wie den von uns durchgeführten ist

gut zu erkennen, ob, und wenn ja, in welchem

Bereich, das jeweilige System Schwierigkeiten

hat. Arbeitet der so belastete Switch korrekt,

muss er in allen Fällen gemäß den »Classof-Service-Regeln« die niedrig priorisierten

Daten zugunsten der höher priorisierten

verwerfen. Ein Datenverlust in der höchsten

Priorität dürfte bei allen unseren Strict-PriorityTests theoretisch nicht vorkommen, nur so

würde der jeweilige Switch die fehlerfreie Übertragung der am höchsten priorisierten Echtzeitapplikation, beispielsweise einer Video-Konferenz, garantieren.

Für die Switches sind pro Zeiteinheit um so

mehr Header-Informationen auszuwerten, um

so kleiner die einzelnen Datenrahmen sind. Ein

Switch wird also zuerst Probleme mit 64-ByteDatenströmen bekommen, wenn er bei der internen Verarbeitungsgeschwindigkeit an seine

Grenzen stößt. Bei großen Datenrahmen können

je nach Design dagegen schneller Probleme mit

dem Speichermanagement beziehungsweise mit

der Größe des überhaupt verfügbaren Pufferspeichers entstehen.

Strict-Priority-Switching

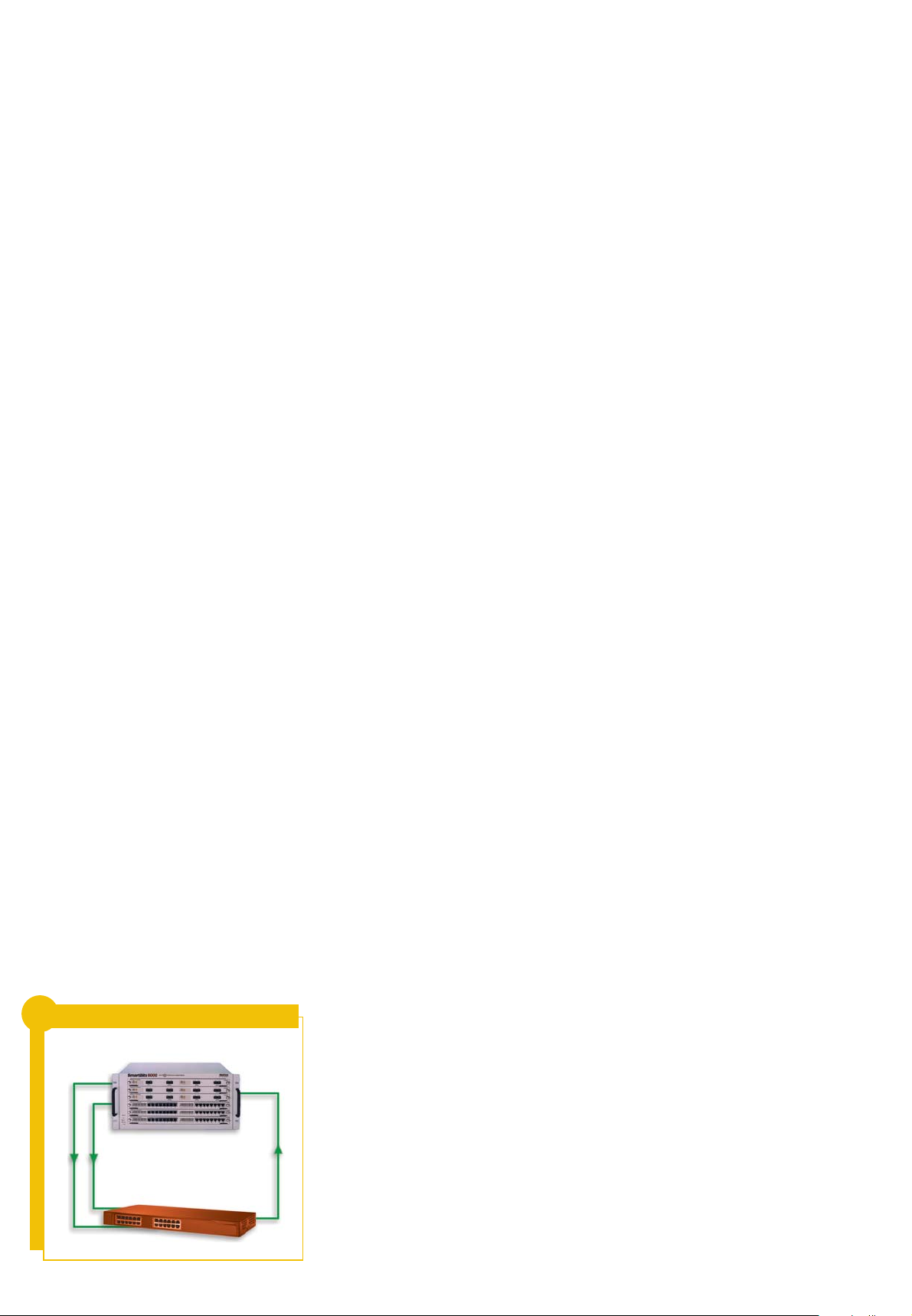

In unserem Gigabit-Ethernet-Switch-Test haben

wir ausschließlich die Gigabit-Ethernet-Ports der

Systeme im Test eingesetzt.

Test-Setup

Gigabit-Ethernet vs. Gigabit-Ethernet

Smartbits

Lastgenerator/Analysator

Switch im Test

16 x Gigabit-Ethernet

4 x Gigabit-Ethernet

Loading...

Loading...