Page 1

Guide de l'utilisateur et de

l'administrateur VMware vSphere Big

Data Extensions

vSphere Big Data Extensions 2.3

Ce document prend en charge la version de chacun des produits

répertoriés, ainsi que toutes les versions publiées par la suite

jusqu'au remplacement dudit document par une nouvelle

édition. Pour rechercher des éditions plus récentes de ce

document, rendez-vous sur :

http://www.vmware.com/fr/support/pubs.

FR-TBD-00

Page 2

Guide de l'utilisateur et de l'administrateur VMware vSphere Big Data Extensions

Vous trouverez la documentation technique la plus récente sur le site Web de VMware à l'adresse :

http://www.vmware.com/fr/support/

Le site Web de VMware propose également les dernières mises à jour des produits.

N’hésitez pas à nous transmettre tous vos commentaires concernant cette documentation à l’adresse suivante :

docfeedback@vmware.com

Copyright © 2013 – 2015 VMware, Inc. Tous droits réservés. Copyright et informations sur les marques.

Cet ouvrage est concédé sous la licence Creative Commons Attribution-NoDerivs 3.0 aux États-Unis

(http://creativecommons.org/licenses/by-nd/3.0/us/legalcode).

VMware, Inc.

3401 Hillview Ave.

Palo Alto, CA 94304

www.vmware.com

2 VMware, Inc.

VMware, Inc.

100-101 Quartier Boieldieu

92042 Paris La Défense

France

www.vmware.com/fr

Page 3

Table des matières

À propos de ce guide 7

À propos de VMware vSphere Big Data Extensions 9

1

Prise en main de Big Data Extensions 9

Big Data Extensions et Project Serengeti 10

À propos de l'architecture de Big Data Extensions 12

À propos des gestionnaires d'applications 13

Installation de Big Data Extensions 17

2

Configuration système requise pour Big Data Extensions 17

Prise en charge d'Unicode UTF-8 et des caractères spéciaux 20

Le programme d'amélioration du produit 22

Déployer le vApp Big Data Extensions dans vSphere Web Client 23

Installer des RPM dans le référentiel Yum du serveur de gestion Serengeti 26

Installer le plug-in Big Data Extensions 27

Configurer les paramètres vCenter Single Sign-On du serveur de gestion Serengeti 29

Se connecter à un serveur de gestion Serengeti 30

Installer le client d'interface de ligne de commande distant Serengeti 31

Accéder à l'interface de ligne de commande Serengeti à l'aide du client d'interface de ligne de

commande distant 31

Mise à niveau de Big Data Extensions 35

3

Préparer la mise à niveau de Big Data Extensions 35

Mettre à niveau le dispositif virtuel Big Data Extensions 36

Mettre à niveau le plug-in Big Data Extensions 37

Mettre à niveau des clusters Big Data Extensions à l'aide de l'interface de ligne de commande

Serengeti 38

Mettre à niveau l' Serengeti CLI 39

Ajouter un serveur Syslog distant 39

VMware, Inc.

Gestion des gestionnaires d'applications 41

4

Ajouter un gestionnaire d'applications à l'aide de vSphere Web Client 41

Modifier un gestionnaire d'applications à l'aide de vSphere Web Client 42

Supprimer un gestionnaire d'applications à l'aide de vSphere Web Client 42

Afficher les gestionnaires d'applications et les distributions à l'aide de vSphere Web Client 42

Afficher les rôles du gestionnaire d'applications et de la distribution à l'aide de vSphere Web

Client 43

Gestion de distributions Hadoop 45

5

Types de déploiement de distribution Hadoop 45

3

Page 4

Guide de l'utilisateur et de l'administrateur VMware vSphere Big Data Extensions

Configurer une distribution Hadoop déployée sur Tarball à l'aide de l'interface de ligne de

commande Serengeti 46

Configuration de Yum et de référentiels Yum 48

Gérer les modèles de nœud 65

6

Tenir à jour une machine virtuelle de modèle Hadoop personnalisée 65

Créer une machine virtuelle de modèle de nœud à l'aide de RHEL Server 6.7 et VMware Tools 66

Prendre en charge plusieurs modèles de machine virtuelle 70

Gérer l'environnement Big Data Extensions 71

7

Ajouter des noms d'utilisateur spécifiques pour la connexion au serveur de gestion Serengeti 71

Modifier le mot de passe du serveur de gestion Serengeti 72

Créer un nom d'utilisateur et un mot de passe pour l'interface de ligne de commande Serengeti 73

Autoriser et vérifier les commandes exécutées en tant qu'utilisateur racine 74

Spécifier un groupe d'utilisateurs dans Active Directory ou LDAP pour utiliser un cluster Hadoop 74

Arrêter et démarrer les services Serengeti 75

Ports utilisés pour la communication entre Big Data Extensions et vCenter Server 76

Vérifier l'état de fonctionnement de l'environnement Big Data Extensions 77

Passer en mode maintenance pour effectuer la sauvegarde et la restauration à l'aide du client

d'interface de ligne de commande Serengeti 86

Sauvegarder et restaurer l'environnement Big Data Extensions 87

Gestion de ressources vSphere pour les clusters 89

8

Ajouter un pool de ressources avec l'interface de ligne de commande Serengeti 89

Supprimer un pool de ressources avec l'interface de ligne de commande Serengeti 90

Mettre à jour les pools de ressources à l'aide de l'interface de ligne de commande Serengeti 90

Ajouter une banque de données dans vSphere Web Client 91

Supprimer une banque de données de vSphere Web Client 92

Mettre à jour les banques de données à l'aide de l'interface de ligne de commande Serengeti 93

Ajouter un contrôleur SCSI Paravirtual pour les disques système et de permutation 94

Ajouter un réseau dans vSphere Web Client 94

Modifier le type de DNS dans vSphere Web Client 95

Reconfigurer un réseau IP statique dans vSphere Web Client 96

Supprimer un réseau de vSphere Web Client 96

Création de clusters Hadoop et HBase 99

9

À propos des types de déploiement de clusters Hadoop et HBase 101

Distributions Hadoop prenant en charge MapReduce v1 et MapReduce v2 (YARN) 101

À propos de la topologie des clusters 102

À propos de l'accès à la base de données HBase 103

Créer un cluster Big Data dans vSphere Web Client 103

Créer un cluster uniquement HBase dans Big Data Extensions 107

Créer un cluster avec un gestionnaire d'applications à l'aide de vSphere Web Client 109

Créer un cluster de calcul uniquement avec un gestionnaire d'applications tiers en utilisant

vSphere Web Client 110

Créer un cluster de calcul du travailleur uniquement à l'aide de vSphere Web Client 110

4 VMware, Inc.

Page 5

Gestion des clusters Hadoop et HBase 113

10

Arrêter et démarrer un cluster dans vSphere Web Client 113

Supprimer un cluster dans vSphere Web Client 114

Agrandir ou réduire un cluster à l'aide de vSphere Web Client 114

Mettre à l'échelle le CPU et la RAM dans vSphere Web Client 115

Utiliser des partages de disque E/S pour fixer la priorité des machines virtuelles de cluster dans

vSphere Web Client 116

À propos de vSphere High Availability et de vSphere Fault Tolerance 117

Modifier le mot de passe utilisateur sur tous les nœuds d'un cluster 117

Reconfigurer un cluster avec l'interface de ligne de commande Serengeti 118

Configurer le nombre de disques de données par groupe de nœuds 120

Récupérer d'une défaillance disque avec le client d'interface de ligne de commande Serengeti 121

Se connecter aux nœuds Hadoop avec le client d'interface de ligne de commande Serengeti 122

Table des matières

Surveillance de l'environnement Big Data Extensions 123

11

Activer le collecteur de données Big Data Extensions 123

Désactiver le collecteur de données Big Data Extensions 124

Afficher l'état d'initialisation du serveur de gestion Serengeti 124

Afficher les clusters provisionnés dans vSphere Web Client 125

Afficher les informations des clusters dans vSphere Web Client 126

Surveiller l'état de HDFS dans vSphere Web Client 127

Surveiller le statut MapReduce dans vSphere Web Client 128

Surveiller l'état de HBase dans vSphere Web Client 129

Accès aux données Hive avec JDBC ou ODBC 131

12

Configurer Hive pour travailler avec JDBC 131

Configurer Hive pour travailler avec ODBC 133

Référence de sécurité Big Data Extensions 135

13

Services, ports réseau et interfaces externes 135

Fichiers de configuration de Big Data Extensions 138

Clé publique, certificat et KeyStore Big Data Extensions 138

Fichiers journaux Big Data Extensions 138

Comptes d'utilisateurs Big Data Extensions 139

Correctifs et mises à jour de sécurité 140

Dépannage 141

14

Fichiers journaux pour le dépannage 142

Configurer les niveaux de journalisation Serengeti 142

Collecter les fichiers journaux à des fins de dépannage 143

Résolution des échecs de création d'un cluster 144

La mise à niveau du dispositif virtuel de Big Data Extensions échoue. 150

Erreur de mise à niveau du cluster lors de l'utilisation du cluster créé dans une version antérieure

de Big Data Extensions 151

Impossible de connecter le plug-in Big Data Extensions au serveur Serengeti 152

Les connexions à vCenter Server échouent. 152

Le serveur de gestion ne peut pas se connecter à vCenter Server 153

VMware, Inc. 5

Page 6

Guide de l'utilisateur et de l'administrateur VMware vSphere Big Data Extensions

Erreur de certificat SSL lors de la connexion à un serveur autre que Serengeti avec la console

vSphere 153

Impossible de redémarrer ou de reconfigurer un cluster pour lequel l'heure n'est pas synchronisée 153

Impossible de redémarrer ou de reconfigurer un cluster après la modification de sa distribution 154

La machine virtuelle ne peut pas obtenir d'adresse IP et la commande échoue. 154

Impossible de modifier l'adresse IP du serveur Serengeti dans vSphere Web Client 155

Une nouvelle instance de plug-in avec un numéro de version identique ou antérieure à une

instance de plug-in précédente ne se charge pas. 155

Le nom d'hôte et le FQDN ne correspondent pas pour le serveur de gestion Serengeti. 156

Les opérations de Serengeti échouent après que vous ayez renommé une ressource dans vSphere. 157

Big Data Extensions Le serveur refuse les noms de ressource comptant au moins deux espaces

blancs à la suite. 157

Les caractères non ASCII ne s'affichent pas correctement. 157

L'exécution de la tâche MapReduce échoue et n'apparaît pas dans l'historique des tâches. 158

Impossible d'envoyer des tâches MapReduce pour les clusters de calcul uniquement avec l'HDFS

Isilon externe 158

La tâche MapReduce ne répond plus sur un cluster PHD ou CDH4 YARN. 159

Impossible de télécharger le paquet à l'aide du plug-in Downloadonly 159

Impossible de trouver des paquets avec la recherche Yum 159

Supprimer HBase Rootdir dans HDFS avant de supprimer le cluster uniquement HBase 160

Index 161

6 VMware, Inc.

Page 7

À propos de ce guide

Guide de l'administrateur et de l'utilisateur de VMware vSphere Big Data Extensions décrit comment installer

VMware vSphere Big Data Extensions™ au sein de votre environnement vSphere, puis comment gérer et

surveiller les clusters Hadoop et HBase à l'aide du plug-in Big Data Extensions pour vSphere Web Client.

Guide de l'administrateur et de l'utilisateur de VMware vSphere Big Data Extensions décrit également comment

effectuer des opérations Hadoop et HBase à l'aide du client d'interface de ligne de commande VMware

Serengeti™, qui permet un contrôle plus important de certaines tâches de gestion système et de création de

clusters Big Data.

Public ciblé

Le guide est destiné aux administrateurs système et aux développeurs qui veulent utiliser

Big Data Extensions pour déployer et gérer des clusters Hadoop. Pour utiliser correctement

Big Data Extensions, il est préférable de connaître VMware® vSphere® ainsi que le déploiement et le

fonctionnement de Hadoop et HBase.

Glossaire VMware Technical Publications

VMware Technical Publications fournit un glossaire des termes qui peuvent éventuellement ne pas vous

être familiers. Pour consulter la définition des termes utilisés dans la documentation technique VMware,

visitez le site Web http://www.vmware.com/support/pubs.

VMware, Inc.

7

Page 8

Guide de l'utilisateur et de l'administrateur VMware vSphere Big Data Extensions

8 VMware, Inc.

Page 9

À propos de VMware vSphere Big

Data Extensions 1

VMware vSphere Big Data Extensions vous permet de déployer et d'utiliser de manière centralisée des

clusters Big Data exécutés sur VMware vSphere. Big Data Extensions simplifie le processus de déploiement

et de provisionnement Hadoop et HBase. Il vous permet aussi de voir en temps réel les services en cours

d'exécution et l'état de leurs hôtes virtuels. Il offre un point central à partir duquel vous pouvez gérer et

surveiller votre cluster Big Data, et incorpore un ensemble complet d'outils susceptibles de vous aider à

optimiser les performances et l'utilisation du cluster.

Ce chapitre aborde les rubriques suivantes :

« Prise en main de Big Data Extensions », page 9

n

« Big Data Extensions et Project Serengeti », page 10

n

« À propos de l'architecture de Big Data Extensions », page 12

n

« À propos des gestionnaires d'applications », page 13

n

Prise en main de Big Data Extensions

Big Data Extensions vous permet de déployer des clusters Big Data. Les tâches incluses dans cette section

décrivent la manière de configurer VMware vSphere® pour une utilisation avec Big Data Extensions, de

déployer le vApp Big Data Extensions, d'accéder aux consoles d'administration VMware vCenter Server® et

d'interface de ligne de commande (CLI), ainsi que de configurer une distribution Hadoop à utiliser avec

Big Data Extensions.

Prérequis

Une bonne compréhension de ce que sont Project Serengeti® et Big Data Extensions vous permet

n

d'appréhender la manière dont ils s'intègrent dans votre workflow Big Data et votre environnement

vSphere.

Vérifiez que les fonctionnalités Big Data Extensions que vous souhaitez utiliser, comme les clusters de

n

calcul uniquement ou les clusters données-calcul séparés, sont prises en charge par Big Data Extensions

pour la distribution Hadoop que vous souhaitez utiliser.

Examinez les fonctionnalités prises en charge par votre distribution Hadoop.

n

VMware, Inc.

9

Page 10

Guide de l'utilisateur et de l'administrateur VMware vSphere Big Data Extensions

Procédure

1 Effectuez l'une des opérations suivantes.

Effectuez la première installation de Big Data Extensions. Passez en revue la configuration système

n

requise, installez vSphere et installez les composants Big Data Extensions : vApp

Big Data Extensions, plug-in Big Data Extensions pour vCenter Server et Serengeti CLI Client.

Effectuez une mise à niveau de Big Data Extensions à partir d'une version précédente. Suivez les

n

étapes de mise à niveau.

2 (Facultatif) Installez et configurez une distribution autre qu'Apache Bigtop à utiliser avec

Big Data Extensions.

Apache Bigtop est inclus dans le serveur de gestion Serengeti, mais vous pouvez utiliser n'importe

quelle distribution Hadoop prise en charge par Big Data Extensions.

Suivant

Une fois que vous avez correctement installé et configuré votre environnement Big Data Extensions, vous

pouvez effectuer les tâches supplémentaires suivantes.

Arrêtez et démarrez les services Serengeti, créez des comptes d'utilisateurs, gérez des mots de passe et

n

connectez-vous à des nœuds de cluster pour résoudre les problèmes.

Gérez les pools de ressources vSphere, les banques de données et les réseaux que vous utilisez pour

n

créer des clusters Hadoop et HBase.

Créez, provisionnez et gérez des clusters Big Data.

n

Surveillez l'état des clusters que vous créez, notamment leurs banques de données, réseaux et pools de

n

ressources, via vSphere Web Client et l'interface de ligne de commande Serengeti.

Sur vos clusters Big Data, exécutez des commandes HDFS, des scripts Hive et Pig, ainsi que des travaux

n

MapReduce, et accédez aux données Hive.

Si vous rencontrez des problèmes en utilisant Big Data Extensions, consultez Chapitre 14,

n

« Dépannage », page 141.

Big Data Extensions et Project Serengeti

Big Data Extensions s'exécute sur Project Serengeti, projet open source lancé par VMware pour automatiser

le déploiement et la gestion des clusters Hadoop et HBase dans des environnements virtuels comme

vSphere.

Big Data Extensions et Project Serengeti fournissent les composants suivants.

Project Serengeti

Projet open source lancé par VMware, Project Serengeti permet aux

utilisateurs de déployer et gérer des clusters Big Data dans un

environnement géré vCenter Server. Les composants majeurs sont ceux de

Serengeti Management Server, qui permettent le provisionnement de cluster,

la configuration logicielle et les services de gestion, ainsi qu'une interface de

ligne de commande. Project Serengeti est disponible sous licence Apache 2.0,

laquelle permet à tout le monde de modifier et de redistribuer Project

Serengeti conformément à ses termes.

Serengeti Management

Server

Fournit l'infrastructure et les services permettant d'exécuter des clusters Big

Data sur vSphere. Serengeti Management Server assure la gestion des

ressources, le placement des machines virtuelles selon la stratégie, le

provisionnement du cluster, la gestion de la configuration logicielle et la

surveillance de l'environnement.

10 VMware, Inc.

Page 11

Chapitre 1 À propos de VMware vSphere Big Data Extensions

Client d'interface de

ligne de commande

Serengeti

Big Data Extensions

Le client d'interface de ligne de commande (CLI, Command-Line Interface)

offre un ensemble complet d'outils et d'utilitaires permettant de surveiller et

de gérer votre déploiement Big Data. Si vous utilisez la version open source

de Serengeti sans Big Data Extensions, l'interface de ligne de commande est

la seule interface par l'intermédiaire de laquelle vous pouvez effectuer des

tâches administratives. Pour plus d'informations sur l'interface de ligne de

commande, consultez le Guide de l'interface de ligne de commande VMware

vSphere Big Data Extensions.

La version commerciale de Project Serengeti, projet open source de VMware,

à savoir Big Data Extensions, est fournie en tant que

vCenter Server Appliance. Big Data Extensions inclut toutes les fonctions de

Project Serengeti, ainsi que les fonctionnalités et composants

supplémentaires suivants.

Support de niveau entreprise par VMware.

n

Distribution Bigtop par la communauté Apache.

n

REMARQUE VMware fournit la distribution Hadoop par souci pratique

mais n'en assure pas le support de niveau entreprise. La distribution

Apache Bigtop est prise en charge par la communauté open source.

Plug-in Big Data Extensions, interface graphique utilisateur intégrée

n

dans vSphere Web Client. Ce plug-in vous permet d'effectuer des tâches

administratives courantes de gestion de l'infrastructure et du cluster

Hadoop.

VMware, Inc. 11

Page 12

CLI GUI

API Rest

Infrastructure d'approvisionnement

de machines virtuelles et d'applications

Gestion de logiciels SPI

Adaptateur

par défaut

Adaptateur

Cloudera

Adaptateur

Ambari

Service Thrift

Gestionde

logiciels

Serveur

Cloudera

Manager

Serveur

Ambari

Guide de l'utilisateur et de l'administrateur VMware vSphere Big Data Extensions

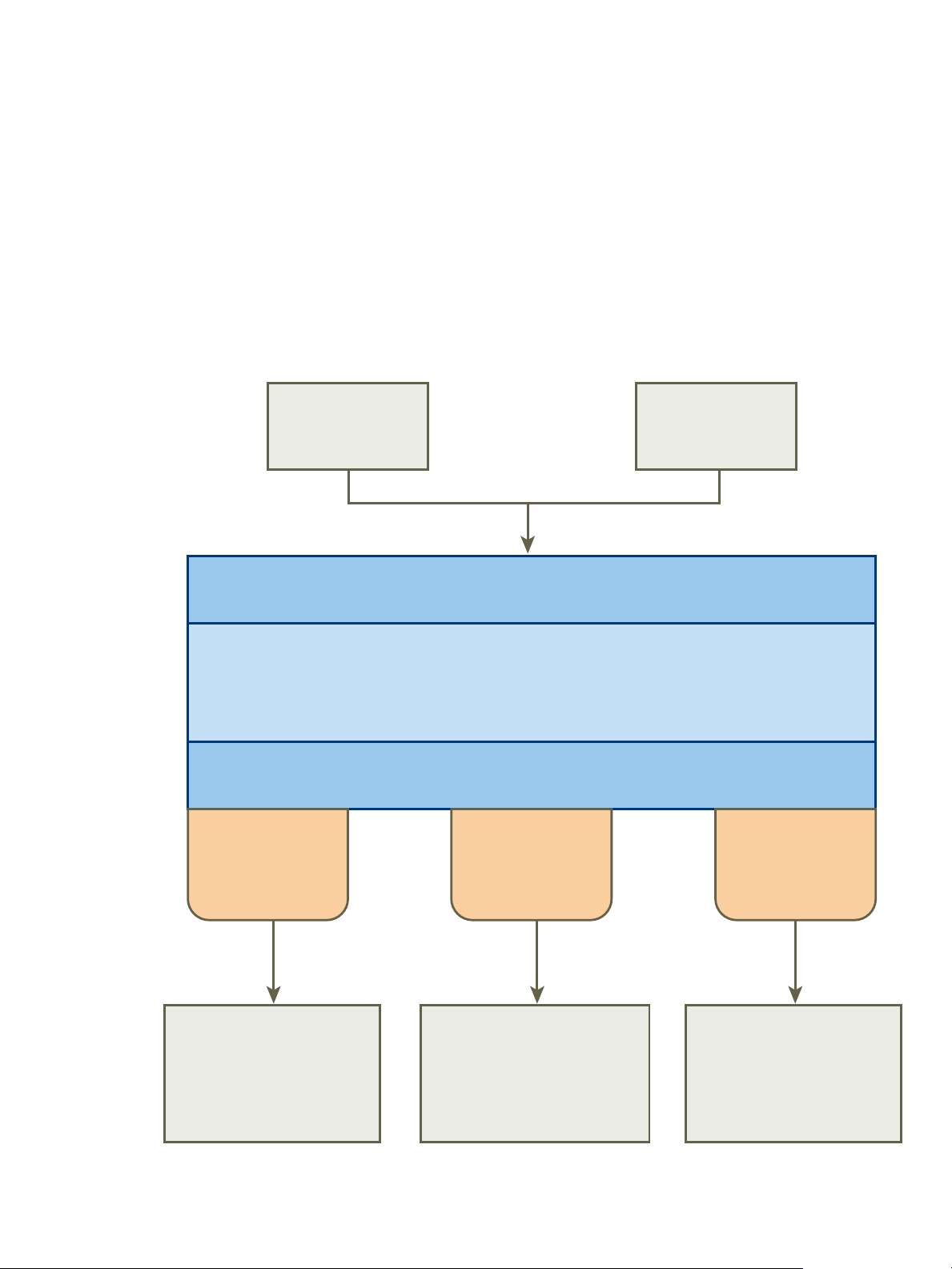

À propos de l'architecture de Big Data Extensions

Serengeti Management Server et la machine virtuelle du modèle Hadoop fonctionnent ensemble pour

configurer et provisionner des clusters Big Data.

Figure 1‑1. Architecture de Big Data Extensions

12 VMware, Inc.

Page 13

Big Data Extensions effectue les étapes suivantes pour déployer un cluster Big Data.

1 Serengeti Management Server recherche les hôtes ESXi dotés de suffisamment de ressources pour faire

fonctionner le cluster avec les paramètres de configuration que vous spécifiez, puis sélectionne les hôtes

ESXi sur lesquels placer des machines virtuelles Hadoop.

2 Serengeti Management Server envoie une demande à vCenter Server pour cloner et configurer les

machines virtuelles à utiliser avec le cluster Big Data.

3 Serengeti Management Server configure le système d'exploitation et les paramètres réseau des

nouvelles machines virtuelles.

4 Chaque machine virtuelle télécharge les modules logiciels Hadoop et les installe conformément aux

informations d'installation et de distribution issues de Serengeti Management Server.

5 Serengeti Management Server configure les paramètres Hadoop pour les nouvelles machines virtuelles

en fonction des paramètres de configuration du cluster que vous spécifiez.

6 Les services Hadoop sont démarrés sur les nouvelles machines virtuelles. À ce stade, vous avez un

cluster en cours d'exécution selon vos paramètres de configuration.

À propos des gestionnaires d'applications

Vous pouvez utiliser Cloudera Manager, Apache Ambari et le gestionnaire d'applications par défaut pour

provisionner et gérer des clusters avec VMware vSphere Big Data Extensions.

Chapitre 1 À propos de VMware vSphere Big Data Extensions

Après avoir ajouté un nouveau gestionnaire d'applications Cloudera Manager ou Ambari à

Big Data Extensions, vous pouvez y rediriger vos tâches de gestion logicielle, notamment la surveillance et

la gestion des clusters.

Vous pouvez utiliser un gestionnaire d'applications pour effectuer les tâches suivantes :

Dresser la liste de toutes les instances de fournisseurs disponibles, des distributions prises en charge et

n

des configurations ou des rôles pour un gestionnaire d'applications et une distribution spécifiques.

Créer des clusters.

n

Surveiller et gérer des services à partir de la console du gestionnaire d'applications.

n

Consultez la documentation de votre gestionnaire d'applications pour identifier les exigences propres aux

outils.

Restrictions

Les restrictions suivantes s'appliquent aux gestionnaires d'applications Cloudera Manager et Ambari :

Pour ajouter un gestionnaire d'applications avec HTTPS, utilisez le nom de domaine complet (FQDN)

n

au lieu de l'URL.

Vous ne pouvez pas renommer un cluster créé avec le gestionnaire d'applications Cloudera Manager ou

n

Ambari.

Vous ne pouvez pas changer les services d'un cluster Big Data à partir de Big Data Extensions si le

n

cluster a été créé avec le gestionnaire d'applications Ambari ou Cloudera Manager.

Pour modifier les services, les configurations ou les deux, vous devez le faire à partir du gestionnaire

n

d'applications sur les nœuds.

Si vous installez de nouveaux services, Big Data Extensions les démarre et les arrête en même temps

que les anciens.

VMware, Inc. 13

Page 14

Guide de l'utilisateur et de l'administrateur VMware vSphere Big Data Extensions

Si vous utilisez un gestionnaire d'applications pour modifier les services et les configurations de

n

clusters Big Data, ces modifications ne peuvent pas être synchronisées à partir de Big Data Extensions.

Les nœuds que vous créez avec Big Data Extensions ne contiennent pas les nouveaux services ni les

nouvelles configurations.

Services et opérations pris en charge par les gestionnaires d'applications

Si vous utilisez Cloudera Manager ou Apache Ambari avec Big Data Extensions, il existe plusieurs services

supplémentaires à votre disposition.

Distributions et gestionnaires d'applications pris en charge

Big Data Extensions prend en charge certains gestionnaires d'applications et certaines distributions Hadoop.

Toutes les fonctionnalités et opérations ne sont pas prises en charge par certaines versions des gestionnaires

d'applications. Le tableau ci-dessous indique les fonctionnalités disponibles avec chacun des gestionnaires

d'applications listés.

Tableau 1‑1. Distributions Hadoop et gestionnaires d'applications pris en charge

Fonctionnalités et

opérations prises en

charge Cloudera Manager

Versions prises en

charge

Distributions prises en

charge

Déploiement

automatique

Liste de clusters,

Arrêter, Démarrer,

Exporter et Reprendre

vSphere High

Availability

vSphere Fault

Tolerance

Multiples réseaux Les multiples

Données-calcul

combinés

Séparation de calcul

de données

5.3-5.4 2.0-2.1 1.7 2.3

CDH 5.3-5.4, OneFS

7.1-7.2

X X X X

X X X X

X X X X

X X X X

réseaux ne sont pas

pris en charge.

X X X X

X X X X

Hortonworks

Ambari Pivotal Ambari

HDP 2.2-2.3, OneFS*

7.1-7.2

Les multiples

réseaux ne sont pas

pris en charge.

PHD 3.0, OneFS*

7.1-7.2

Les multiples

réseaux ne sont pas

pris en charge.

Gestionnaire

d'applications par

défaut

Bigtop 1.0, CDH

5.3-5.4, HDP 2.1, PHD

2.0-2.1, MapR 4.1-5.0

et OneFS 7.1-7.2

Non pris en charge

avec MapR.

14 VMware, Inc.

Page 15

Chapitre 1 À propos de VMware vSphere Big Data Extensions

Tableau 1‑1. Distributions Hadoop et gestionnaires d'applications pris en charge (suite)

Fonctionnalités et

opérations prises en

charge Cloudera Manager

Calcul uniquement X Ambari peut

Cluster HBase X X X X

HBase uniquement Non pris en charge

Topologie/HVE

Hadoop

Configuration Hadoop Pris en charge via

Composants de

l'écosystème Hadoop

X X X La topologie n'est pas

l'interface Web du

gestionnaire

d'applications.

Pile pleine via

Cloudera Manager.

Hortonworks

Ambari Pivotal Ambari

Ambari peut

provisionner des

clusters de calcul

uniquement avec

Isilon OneFS.

Reportez-vous à la

documentation EMC

Isilon Hadoop

Starter Kit for

Hortonworks pour

obtenir des

informations sur la

configuration de

Ambari et de

Isilon OneFS.

Pris en charge via

l'interface Web du

gestionnaire

d'applications.

Pile pleine via

Ambari.

provisionner des

clusters de calcul

uniquement avec

Isilon OneFS.

Reportez-vous à la

documentation EMC

Isilon Hadoop

Starter Kit for

Hortonworks pour

obtenir des

informations sur la

configuration de

Ambari et de

Isilon OneFS.

Pris en charge via

l'interface Web du

gestionnaire

d'applications.

Pile pleine via

Ambari.

Gestionnaire

d'applications par

défaut

Non pris en charge

avec MapR.

avec MapR.

prise en charge avec

MapR.

HVE n'est pris en

charge qu'avec PHD.

Non pris en charge

avec MapR.

Pig, Hive, Hive Server

et Zookeeper.

Prise en charge des distributions Hadoop dans Isilon OneFS

Si vous souhaitez utiliser Isilon OneFS, vérifiez d'abord si votre distribution Hadoop est compatible avec

OneFS. Reportez-vous à la section Distributions Hadoop prises en charge dans OneFS du site Internet

d'EMC.

REMARQUE Big Data Extensions ne prend pas nativement en charge le provisionnement des clusters de

calcul uniquement avec Ambari Manager. Cependant, Ambari peut provisionner des clusters de calcul

uniquement avec Isilon OneFS. Reportez-vous à la documentation EMC Isilon Hadoop Starter Kit for

Hortonworks pour obtenir des informations sur la configuration de Ambari et de Isilon OneFS.

Services pris en charge sur Cloudera Manager et Ambari

Tableau 1‑2. Services pris en charge sur Cloudera Manager et Ambari

Nom du service Cloudera Manager 5.3, 5.4 Ambari 1.6, 1.7

Falcon X

Flume X X

Ganglia X

HBase X X

HCatalog X

VMware, Inc. 15

Page 16

Guide de l'utilisateur et de l'administrateur VMware vSphere Big Data Extensions

Tableau 1‑2. Services pris en charge sur Cloudera Manager et Ambari (suite)

Nom du service Cloudera Manager 5.3, 5.4 Ambari 1.6, 1.7

HDFS X X

Hive X X

Hue X X

Impala X

MapReduce X X

Nagios X

Oozie X X

Pig X

Sentry

Solr X

Spark X

Sqoop X X

Storm X

TEZ X

WebHCAT X

YARN X X

Zookeeper X X

À propos du niveau de service vSphere High Availability pour Ambari

Ambari prend en charge la fonction NameNode HA. Toutefois, vous devez configurer cette fonction de

sorte qu'elle utilise votre déploiement Hadoop. Reportez-vous à la section Haute disponibilité NameNode

pour Hadoop de la documentation Hortonworks.

À propos du niveau de service vSphere High Availability pour Cloudera

Les distributions Cloudera offrent la prise en charge suivante de la haute disponibilité vSphere de niveau de

service.

Cloudera avec MapReduce v1 offre une prise en charge de la haute disponibilité vSphere de niveau de

n

service pour JobTracker.

Cloudera offre sa propre prise en charge de la haute disponibilité de niveau de service pour NameNode

n

via HDFS2.

Pour plus d'informations sur la manière d'utiliser un gestionnaire d'applications avec l'interface de ligne de

commande, consultez le Guide de l'interface de ligne de commande VMware vSphere Big Data Extensions.

16 VMware, Inc.

Page 17

Installation de Big Data Extensions 2

Pour installer Big Data Extensions afin de pouvoir créer et provisionner des clusters Big Data, vous devez

installer les composants Big Data Extensions dans l'ordre indiqué.

Suivant

Si vous voulez créer des clusters sur une distribution Hadoop autre qu'Apache Bigtop, incluse dans

Serengeti Management Server, installez et configurez la distribution afin de l'utiliser avec

Big Data Extensions.

Ce chapitre aborde les rubriques suivantes :

« Configuration système requise pour Big Data Extensions », page 17

n

« Prise en charge d'Unicode UTF-8 et des caractères spéciaux », page 20

n

« Le programme d'amélioration du produit », page 22

n

« Déployer le vApp Big Data Extensions dans vSphere Web Client », page 23

n

« Installer des RPM dans le référentiel Yum du serveur de gestion Serengeti », page 26

n

« Installer le plug-in Big Data Extensions », page 27

n

« Configurer les paramètres vCenter Single Sign-On du serveur de gestion Serengeti », page 29

n

« Se connecter à un serveur de gestion Serengeti », page 30

n

« Installer le client d'interface de ligne de commande distant Serengeti », page 31

n

« Accéder à l'interface de ligne de commande Serengeti à l'aide du client d'interface de ligne de

n

commande distant », page 31

Configuration système requise pour Big Data Extensions

Avant de commencer à déployer Big Data Extensions, votre système doit remplir toutes les conditions

préalables liées à vSphere, aux clusters, aux réseaux, au stockage, au matériel et aux licences.

Big Data Extensions requiert que vous installiez et configuriez vSphere et que votre environnement réponde

aux besoins en ressources minimaux. Assurez-vous de posséder des licences pour les composants VMware

de votre déploiement.

Exigences vSphere

VMware, Inc. 17

Avant d'installer Big Data Extensions, configurez les produits VMware

suivants.

Installez vSphere 5.5 (ou version ultérieure) Enterprise ou Enterprise

n

Plus.

Page 18

Guide de l'utilisateur et de l'administrateur VMware vSphere Big Data Extensions

Quand vous installez Big Data Extensions sur vSphere 5.5 ou version

n

ultérieure, utilisez VMware® vCenter™ Single Sign-On pour fournir

l'authentification utilisateur. Quand vous vous connectez à vSphere 5.5

ou version ultérieure, vous transmettez l'authentification au serveur

vCenter Single Sign-On, que vous pouvez configurer avec plusieurs

sources d'identité comme Active Directory et OpenLDAP. Quand

l'authentification réussit, votre nom d'utilisateur et votre mot de passe

sont échangés contre un jeton de sécurité qui est utilisé pour accéder aux

composants vSphere comme Big Data Extensions.

Si votre instance de vCenter Server utilise un FQDN, assurez-vous de le

n

configurer correctement à l'installation de vCenter Server.

Configurez tous les hôtes ESXi de sorte à utiliser le même serveur NTP

n

(Network Time Protocol).

Sur chaque hôte ESXi, ajoutez le serveur NTP à la configuration d'hôte,

n

puis, dans la liste Stratégie de démarrage de la configuration d'hôte,

sélectionnez Démarrer et arrêter avec l'hôte. Le démon NTP veille à ce

que les processus dépendant de l'heure se produisent de manière

synchronisée sur tous les hôtes.

Paramètres cluster

Paramètres réseau

Configurez votre cluster avec les paramètres suivants.

Activez la haute disponibilité vSphere et VMware vSphere® Distributed

n

Resource Scheduler™.

Activez la surveillance de l'hôte.

n

Activez le contrôle d'admission et définissez la stratégie souhaitée. La

n

stratégie par défaut consiste à tolérer une seule défaillance de l'hôte.

Définissez une priorité élevée pour le redémarrage de la machine

n

virtuelle.

Définissez la surveillance de la machine virtuelle sur une surveillance de

n

la machine virtuelle et de l'application.

Définissez une sensibilité élevée pour la surveillance.

n

Activez vMotion et la journalisation de la tolérance aux pannes.

n

Tous les hôtes du cluster ont le VT matériel activé dans le BIOS.

n

Pour le port VMkernel du réseau de gestion, vMotion et la journalisation

n

de la tolérance aux pannes sont activés.

Big Data Extensions peut déployer des clusters sur un seul réseau ou utiliser

plusieurs réseaux. L'environnement détermine la manière dont les groupes

de ports attachés aux cartes réseau sont configurés et quel réseau soutient

chaque groupe de ports.

Vous pouvez utiliser soit un vSwitch, soit un vDS (vSphere Distributed

Switch) pour assurer le soutien du groupe de ports par un cluster Serengeti.

Un vDS joue le rôle d'un commutateur virtuel unique sur tous les hôtes

attachés tandis qu'un vSwitch est individuel pour chaque port et requiert la

configuration manuelle du groupe de ports.

18 VMware, Inc.

Page 19

Chapitre 2 Installation de Big Data Extensions

Quand vous configurez vos réseaux à utiliser avec Big Data Extensions,

vérifiez que les ports suivants sont ouverts en tant que ports d'écoute.

Les ports 8080 et 8443 sont utilisés par l'interface utilisateur du plug-in

n

Big Data Extensions et le client d'interface de ligne de commande

Serengeti.

Le port 5480 est utilisé par vCenter Single Sign-On à des fins de

n

surveillance et de gestion.

Le port 22 est utilisé par les clients SSH.

n

Pour éviter d'avoir à ouvrir un port de pare-feu réseau pour accéder aux

n

services Hadoop, connectez-vous au nœud client Hadoop. À partir de ce

nœud, vous pouvez en effet accéder à votre cluster.

Pour vous connecter à Internet (par exemple, pour créer un référentiel

n

Yum interne à partir duquel installer des distributions Hadoop), vous

pouvez utiliser un proxy.

Pour permettre les communications, assurez-vous que les pare-feu et

n

filtres Web ne bloquent pas le serveur de gestion Serengeti ni d'autres

nœuds Serengeti.

Stockage en

attachement direct

Ne pas utiliser

Big Data Extensions en

conjonction avec

vSphere Storage DRS

La migration des

machines virtuelles

dans vCenter Server

peut perturber la

stratégie de placement

des machines virtuelles

Attachez et configurez un stockage en attachement direct sur le contrôleur

physique pour présenter chaque disque séparément au système

d'exploitation. Cette configuration est couramment désignée par l'acronyme

JBOD (Just A Bunch Of Disks, juste un paquet de disques). Créez des

banques de données VMFS sur le stockage en attachement direct en

respectant les recommandations suivantes liées aux lecteurs de disque.

Entre 8 et 12 lecteurs de disque par hôte. Plus le nombre de lecteurs de

n

disque par hôte est élevé, meilleures sont les performances.

Entre 1 et 1,5 lecteurs de disque par cœur de processeur.

n

Lecteurs de disques Serial ATA 7 200 tr/min.

n

Avant de les créer, Big Data Extensions place les machines virtuelles sur les

hôtes en fonction des ressources disponibles, des meilleures pratiques

Hadoop et des stratégies de placement définies par l'utilisateur. De ce fait,

évitez de déployer Big Data Extensions dans les environnements vSphere en

conjonction avec Storage DRS. Storage DRS équilibre en permanence

l'utilisation de l'espace de stockage et la charge d'E/S de stockage pour

respecter les niveaux de service applicatif dans les environnements

spécifiques. Si Storage DRS est utilisé avec Big Data Extensions, les stratégies

de placement du cluster Big Data de vos machines virtuelles ne seront pas

respectées.

Big Data Extensions place les machines virtuelles en fonction des ressources

disponibles, des meilleures pratiques Hadoop et des stratégies de placement

définies par l'utilisateur que vous spécifiez. De ce fait, DRS est désactivé sur

toutes les machines virtuelles créées dans l'environnement

Big Data Extensions. Cela empêche la migration automatique des machines

virtuelles par vSphere, mais ne vous empêche pas de déplacer

accidentellement les machines virtuelles avec l'interface utilisateur de

vCenter Server. Cela peut enfreindre la stratégie de placement définie dans

Big Data Extensions. Par exemple, le nombre d'instances par hôte et les

associations de groupes peuvent ne pas être respectés.

VMware, Inc. 19

Page 20

Guide de l'utilisateur et de l'administrateur VMware vSphere Big Data Extensions

Besoins en ressources

du serveur de gestion et

des modèles vSphere

Besoins en ressources

du cluster Hadoop

Configuration matérielle

requise pour

l'environnement

vSphere et

Big Data Extensions

Pool de ressources doté d'au moins 27,5 Go de RAM.

n

Espace disque de 40 Go ou plus (recommandé) pour les disques virtuels

n

du serveur de gestion et du modèle Hadoop.

L'espace libre de banque de données n'est pas inférieur à la taille totale

n

requise par le cluster Hadoop, outre les disques d'échange pour chaque

nœud Hadoop égal à la taille de mémoire demandée.

Le réseau est configuré sur tous les hôtes ESXi appropriés et une

n

connectivité existe avec le réseau utilisé par le serveur de gestion.

La haute disponibilité vSphere est activée pour le nœud master si la

n

protection de la haute disponibilité vSphere est nécessaire. Pour utiliser

la haute disponibilité ou la tolérance aux pannes vSphere afin de

protéger le nœud master Hadoop, vous devez utiliser le stockage

partagé.

Le matériel de l'hôte est répertorié dans le Guide de compatibilité VMware.

Pour obtenir des performances optimales à l'exécution, installez votre

environnement vSphere et Big Data Extensions sur le matériel suivant.

Double CPU quadricœurs ou plus avec Hyper-Threading activé. Si vous

n

pouvez estimer votre charge de travail de calcul, envisagez d'utiliser un

CPU plus puissant.

Utilisez la haute disponibilité et deux blocs d'alimentation pour la

n

machine hôte du nœud master.

Entre 4 et 8 Go de mémoire pour chaque cœur de processeur, avec 6 %

n

de traitement pour la virtualisation.

Utilisez une interface Ethernet de 1 Go ou plus pour fournir la bande

n

passante réseau adéquate.

Prise en charge de

l'hôte et de la machine

virtuelle testés

Licences vSphere

La prise en charge maximale de l'hôte et de la machine virtuelle qui a été

confirmée par une exécution correcte avec Big Data Extensions comprend

256 hôtes physiques exécutant un total de 512 machines virtuelles.

Vous devez disposer d'une licence vSphere Enterprise ou supérieure pour

utiliser la haute disponibilité VMware vSphere et vSphere DRS.

Prise en charge d'Unicode UTF-8 et des caractères spéciaux

Big Data Extensions prend en charge le niveau 3 de l'internationalisation (I18N). Cependant, il existe des

ressources que vous spécifiez qui n'offrent pas de prise en charge UTF-8. Vous pouvez uniquement utiliser

des noms d'attribut ASCII composés de caractères alphanumériques et de traits de soulignement (_) pour

ces ressources.

Big Data Extensions prend en charge Unicode UTF-8

Les ressources vCenter Server que vous spécifiez avec l'interface de ligne de commande et vSphere Web

Client peuvent être exprimées avec des traits de soulignement (_), des tirets (-), des espaces et la totalité des

lettres et chiffres de toute langue. Par exemple, vous pouvez spécifier des ressources comme les banques de

données étiquetées à l'aide de caractères étendus.

20 VMware, Inc.

Page 21

Chapitre 2 Installation de Big Data Extensions

Quand vous utilisez un système d'exploitation Linux, vous devez configurer le système de manière à utiliser

un codage UTF-8 propre à vos paramètres régionaux. Par exemple, pour utiliser le français de France,

spécifiez le codage de paramètres régionaux suivant : fr_FR.UTF-8. Reportez-vous à la documentation de

votre fournisseur pour plus d'informations sur la configuration du codage UTF-8 pour votre environnement

Linux.

Prise en charge des caractères spéciaux

Les ressources vCenter Server suivantes peuvent comporter un point (.) dans leur nom, ce qui vous permet

de les sélectionner à la fois avec l'interface de ligne de commande et vSphere Web Client.

nom de groupe de ports

n

nom de cluster

n

nom de pool de ressources

n

nom de banque de données

n

L'utilisation d'un point n'est pas autorisée dans le nom de la ressource Serengeti.

Ressources exclues de la prise en charge Unicode UTF-8

Le fichier de spécification de cluster Serengeti, le fichier de manifeste et le fichier de mappage racks-hôtes de

topologie n'offrent pas de prise en charge UTF-8. Quand vous créez ces fichiers pour définir les nœuds et

ressources que le cluster va utiliser, utilisez uniquement des noms d'attributs ASCII composés de caractères

alphanumériques et de traits de soulignement (_).

Les noms de ressources suivants sont exclus de la prise en charge UTF-8 :

nom de cluster

n

nom nodeGroup

n

nom de nœud

n

nom de machine virtuelle

n

Les attributs suivants inclus dans le fichier de spécification de cluster Serengeti sont exclus de la prise en

charge UTF-8 :

nom de distribution

n

rôle

n

configuration de cluster

n

type de stockage

n

haFlag

n

instanceType

n

groupAssociationsType

n

Le nom de rack dans le fichier de mappage racks-hôtes de topologie et le champ placementPolicies du

fichier de spécification de cluster Serengeti sont également exclus de la prise en charge UTF-8.

VMware, Inc. 21

Page 22

Guide de l'utilisateur et de l'administrateur VMware vSphere Big Data Extensions

Le programme d'amélioration du produit

Vous pouvez configurer Big Data Extensions de sorte qu'il collecte des données afin de nous aider à

améliorer votre expérience utilisateur des produits VMware. La section suivante contient des informations

importantes sur le programme d'amélioration du produit VMware.

Le programme d'amélioration du produit vise à identifier et à régler rapidement les problèmes qui peuvent

affecter votre expérience. Si vous choisissez de participer au programme d'amélioration du produit,

Big Data Extensions enverra régulièrement des données anonymes à VMware. Nous utiliserons ces données

à des fins de développement de produits et de résolution des problèmes.

Avant de collecter des données, VMware anonymise tous les champs contenant des informations propres à

votre entreprise. VMware rend ces champs neutres en hachant leur valeur réelle. Lorsqu'une valeur hachée

est collectée, VMware n'est pas en mesure d'identifier la valeur réelle, mais détecte les changements qu'elle

subit lorsque vous modifiez votre environnement.

Catégories d'information dans les données collectées

Lorsque vous choisissez de participer au programme d'amélioration du produit VMware (CEIP), VMware

obtient des données des catégories suivantes :

Données de

configuration

Données sur l'utilisation

des fonctions

Données performances

Données sur votre configuration des produits VMware et informations liées

à votre environnement informatique. Exemples de données de

configuration : informations sur la version des produits VMware, sur le

matériel et les logiciels utilisés dans votre environnement, paramètres de

configuration des produits et informations sur votre environnement réseau.

Les données de configuration peuvent inclure des versions hachées des ID et

des adresses MAC et IP de vos périphériques.

Données sur votre utilisation des produits et services VMware. Exemples de

données sur l'utilisation des fonctions : informations sur les fonctions

utilisées, indicateurs d'activité dans l'interface utilisateur et informations sur

vos appels API.

Données sur les performances des produits et services VMware. Exemples de

données sur les performances : indicateurs de performance et échelle des

produits et services VMware, temps de réponse des interfaces utilisateur et

informations sur vos appels d'API.

Activation et désactivation de la collecte des données

Par défaut, l'inscription au programme d'amélioration du produit est activée pendant l'installation. Vous

avez la possibilité de désactiver ce service à ce moment-là. Vous pouvez également mettre fin à votre

participation au programme à tout moment et ainsi arrêter d'envoyer des données à VMware. Reportezvous à « Désactiver le collecteur de données Big Data Extensions », page 124.

Pour toute question ou inquiétude concernant le programme d'amélioration du produit pour Log Insight,

contactez bde-info@vmware.com.

22 VMware, Inc.

Page 23

Chapitre 2 Installation de Big Data Extensions

Déployer le vApp Big Data Extensions dans vSphere Web Client

Le déploiement du vApp Big Data Extensions constitue la première étape pour rendre votre cluster

opérationnel avec Big Data Extensions.

Prérequis

Installez et configurez vSphere.

n

Configurez tous les hôtes ESXi pour utiliser le même serveur NTP.

n

Sur chaque hôte ESXi, ajoutez le serveur NTP à la configuration d'hôte, puis, dans la liste Stratégie

n

de démarrage de la configuration d'hôte, sélectionnez Démarrer et arrêter avec l'hôte. Le démon

NTP veille à ce que les processus dépendant de l'heure se produisent de manière synchronisée sur

tous les hôtes.

Lorsque vous installez Big Data Extensions sur vSphere 5.5 ou version ultérieure, utilisez vCenter

n

Single Sign-On pour fournir l'authentification utilisateur.

Vérifiez que vous possédez une licence vSphere Enterprise pour chaque hôte sur lequel vous déployez

n

des nœuds Hadoop virtuels. Vous gérez vos licences vSphere dans vSphere Web Client ou dans

vCenter Server.

Installez le plug-in Client Integration pour vSphere Web Client. Ce plug-in permet le déploiement OVF

n

sur votre système de fichiers local.

REMARQUE Selon les paramètres de sécurité de votre navigateur, vous devrez peut-être accepter le

plug-in lors de sa première utilisation.

Téléchargez Big Data Extensions OVA depuis le site de téléchargement VMware.

n

Vérifiez que vous avez au moins 40 Go d'espace disque disponible pour OVA. Vous avez besoin

n

d'autres ressources pour le cluster Hadoop.

Assurez-vous de connaître l'URL du service de recherche vCenter Single Sign-On pour votre service

n

vCenter Single Sign-On.

Si vous installez Big Data Extensions sur vSphere 5.5 ou version ultérieure, veillez à ce que votre

environnement inclue vCenter Single Sign-On. Utilisez vCenter Single Sign-On pour fournir

l'authentification utilisateur sur vSphere 5.5 ou version ultérieure.

Lisez la description du programme d'amélioration du produit et décidez si vous souhaitez collecter des

n

données et les envoyer à VMware afin de contribuer à améliorer l'expérience client dans

Big Data Extensions. Reportez-vous à « Le programme d'amélioration du produit », page 22.

Procédure

1 Dans vSphere Web Client, sélectionnez un pool de ressources de niveau supérieur, puis Actions >

Déployer le modèle OVF.

Sélectionnez un pool de ressources de niveau supérieur : Les pools de ressources enfants ne sont pas

pris en charge par Big Data Extensions même si vous pouvez en sélectionner un. Si vous en sélectionnez

un, vous ne pouvez pas créer de clusters Big Data avec Big Data Extensions.

2 Choisissez l'emplacement dans lequel Big Data Extensions OVA réside et cliquez sur Suivant.

Option Description

Déployez à partir du fichier

Déployez à partir d'une URL

Parcourez votre système de fichiers pour un modèle OVF ou OVA.

Tapez l'URL d'un modèle OVF ou OVA situé sur Internet. Par exemple :

http://vmware.com/VMTN/appliance.ovf.

VMware, Inc. 23

Page 24

Guide de l'utilisateur et de l'administrateur VMware vSphere Big Data Extensions

3 Consultez la page des détails du modèle OVF et cliquez sur Suivant.

4 Acceptez le contrat de licence, puis cliquez sur Suivant.

5 Spécifiez un nom pour le vApp, sélectionnez un centre de données cible pour OVA, puis cliquez sur

Suivant.

Les seuls caractères valides dans les noms de vApp Big Data Extensions sont les caractères

alphanumériques et les traits de soulignement. Le nom de vApp doit comprendre moins de

60 caractères. Quand vous choisissez le nom de vApp, tenez également compte de la manière dont vous

allez nommer vos clusters. Ensemble, les noms de vApp et de cluster doivent comprendre moins de

80 caractères.

6 Sélectionnez un stockage partagé pour OVA et cliquez sur Suivant.

Si le stockage partagé n'est pas disponible, un stockage local est acceptable.

7 Pour chaque réseau spécifié dans le modèle OVF, sélectionnez un réseau dans la colonne Réseaux de

destination de votre infrastructure pour configurer le mappage réseau.

Le premier réseau permet au serveur de gestion de communiquer avec votre cluster Hadoop. Le second

réseau permet au serveur de gestion de communiquer avec vCenter Server. Si votre déploiement

vCenter Server n'utilise pas IPv6, vous pouvez spécifier le même réseau de destination IPv4 à utiliser

par les deux réseaux sources.

24 VMware, Inc.

Page 25

Chapitre 2 Installation de Big Data Extensions

8 Configurez les paramètres réseau de votre environnement, puis cliquez sur Suivant.

a Entrez les paramètres réseau qui permettent au serveur de gestion de communiquer avec votre

cluster Hadoop.

Utilisez un réseau IPv4 (IP) statique. Une adresse IPv4 correspond à quatre nombres séparés par

des points comme dans aaa.bbb.ccc.ddd, où chaque plage numérique est comprise entre 0 et 255.

Vous devez entrer un masque de réseau, comme 255.255.255.0, ainsi qu'une adresse de passerelle,

comme 192.168.1.253.

Si vCenter Server, tout hôte ESXi ou un référentiel de distribution Hadoop sont résolus à l'aide

d'un nom de domaine complet (FQDN, Fully Qualified Domain Name), vous devez entrer une

adresse DNS. Entrez l'adresse IP du serveur DNS dans Serveur DNS 1. S'il existe un serveur DNS

secondaire, entrez son adresse IP dans Serveur DNS 2.

REMARQUE Vous ne pouvez pas utiliser un pool IP partagé avec Big Data Extensions.

b (Facultatif) Si vous utilisez IPv6 entre le serveur de gestion et vCenter Server, cochez la case

Activer la connexion Ipv6.

Entrez l'adresse IPv6 ou le FQDN de vCenter Server. La taille de l'adresse IPv6 s'élève à 128 bits. La

représentation préférée de l'adresse IPv6 est : xxxx:xxxx:xxxx:xxxx:xxxx:xxxx:xxxx:xxxx où chaque

x est un chiffre hexadécimal qui représente 4 bits. Les adresses IPv6 vont de

0000:0000:0000:0000:0000:0000:0000:0000 à ffff:ffff:ffff:ffff:ffff:ffff:ffff:ffff. Par commodité, une

adresse IPv6 peut être abrégée sous la forme d'une notation plus courte en appliquant les règles ciaprès.

Supprimez le ou les zéros non significatifs de tous les groupes de chiffres hexadécimaux. Cette

n

suppression est généralement appliquée soit à tous les zéros non significatifs, soit à aucun. Par

exemple, le groupe 0042 est converti en 42.

Remplacez les sections consécutives de zéros par un double deux-points (::). Vous pouvez

n

utiliser le double deux-points une seule fois dans une adresse, car en utiliser plusieurs rendrait

l'adresse imprécise. La norme RFC 5952 recommande de ne pas utiliser de double deux-points

pour représenter une section unique de zéros omise.

L'exemple suivant montre comment ces règles sont appliquées à l'adresse

2001:0db8:0000:0000:0000:ff00:0042:8329.

La suppression de tous les zéros non significatifs permet d'obtenir l'adresse

n

2001:db8:0:0:0:ff00:42:8329.

L'omission des sections consécutives de zéros permet d'obtenir l'adresse

n

2001:db8::ff00:42:8329.

Consultez la norme RFC 4291 pour plus d'informations sur la notation des adresses IPv6.

9 Vérifiez que la case Initialiser les ressources est cochée et cliquez sur Suivant.

Si la case n'est pas cochée, le pool de ressources, la banque de données et la connexion réseau affectés à

vApp ne sont pas ajoutés à Big Data Extensions.

Si vous n'ajoutez pas le pool de ressources, la banque de données et le réseau quand vous déployez

vApp, utilisez vSphere Web Client ou Serengeti CLI Client pour spécifier des informations s'y

rapportant avant de créer un cluster Hadoop.

10 Exécutez l'URL du service de recherche vCenter Single Sign-On pour activer vCenter Single Sign-On.

Si vous utilisez vCenter 5.x, utilisez l'URL suivante : https://FQDN_ou_IP_de_SSO_SERVER:

n

7444/lookupservice/sdk

VMware, Inc. 25

Page 26

Guide de l'utilisateur et de l'administrateur VMware vSphere Big Data Extensions

Si vous utilisez vCenter 6.0, utilisez l'URL suivante : https://FQDN_de_SSO_SERVER:

n

443/lookupservice/sdk

Si vous ne renseignez pas l'URL, vCenter Single Sign-On est désactivé.

11 Pour désactiver la collecte de données Big Data Extensions, décochez la case Programme d'amélioration

du produit.

12 (Facultatif) Pour désactiver l'enregistrement automatique du plug-in Web Big Data Extensions,

décochez la case d'activation correspondante.

Par défaut, la case d'activation de l'enregistrement automatique du plug-in Web Big Data Extensions est

cochée. Lorsque vous vous connectez au client Web de Big Data Extensions pour la première fois, il se

connecte automatiquement au Serengeti management server.

13 Spécifiez un serveur Syslog distant, tel que VMware vRealize Log Insight, auquel Big Data Extensions

peut envoyer des informations de journalisation à travers le réseau.

Il s'agit du serveur Syslog recevant et gérant les journaux qui contrôle les paramètres de rétention, de

rotation et de division de ceux-ci. Big Data Extensions ne peut pas configurer ni contrôler la gestion des

journaux sur un serveur Syslog distant. Pour en savoir plus sur la gestion des journaux, reportez-vous à

la documentation relative au serveur Syslog.

Quelle que soit la configuration Syslog supplémentaire spécifiée avec cette option, les journaux

continuent d'être placés dans les emplacements par défaut de l'environnement Big Data Extensions.

14 Vérifiez les liaisons vService et cliquez sur Suivant.

15 Vérifiez les informations d'installation, puis cliquez sur Terminer.

vCenter Server déploie Big Data Extensions vApp. Quand le déploiement est terminé, deux machines

virtuelles sont disponibles dans vApp :

La machine virtuelle du serveur de gestion, management-server (également appelée

n

Serengeti Management Server), qui est démarrée dans le cadre du déploiement OVA.

La machine virtuelle de modèle de nœud, node-template, n'est pas allumée. Big Data Extensions

n

clone les nœuds Hadoop à partir de ce modèle lors du provisionnement d'un cluster. Ne démarrez

pas ou n'arrêtez pas cette machine virtuelle sans bonne raison. Le modèle n'inclut pas de

distribution Hadoop.

IMPORTANT Ne supprimez pas de fichiers dans le répertoire /opt/serengeti/.chef. Si vous supprimez

l'un de ces fichiers, comme serengeti.pem, les mises à niveau ultérieures de Big Data Extensions

risquent d'échouer sans afficher de notifications d'erreur.

Suivant

Installez le plug-in Big Data Extensions dans vSphere Web Client. Reportez-vous à « Installer le plug-in Big

Data Extensions », page 27.

Si la case Initialiser les ressources n'est pas cochée, ajoutez des ressources au serveur Big Data Extensions

avant de créer un cluster Hadoop.

Installer des RPM dans le référentiel Yum du serveur de gestion Serengeti

Installer les packages Red Hat Package Manager (RPM) wsdl4j et mailx dans le référentiel Yum interne de

Serengeti Management Server.

Les packages RPM wsdl4j et mailx ne sont pas intégrés dans Big Data Extensions en raison des contrats de

licence. De ce fait, vous devez les installer dans le référentiel Yum interne de Serengeti Management Server.

26 VMware, Inc.

Page 27

Chapitre 2 Installation de Big Data Extensions

Prérequis

Déployez le vApp Big Data Extensions.

Procédure

1 Ouvrez une interface de commande, comme Bash ou PuTTY, puis connectez-vous au

Serengeti Management Server en tant qu'utilisateur serengeti.

2 Téléchargez et installez les packages RPM wsdl4j et mailx.

Si Serengeti Management Server peut se connecter à Internet, exécutez les commandes comme

n

indiqué dans l'exemple ci-dessous pour télécharger les RPM, copiez les fichiers dans le répertoire

requis, puis créez un référentiel.

umask 022

cd /opt/serengeti/www/yum/repos/centos/6/base/RPMS/

wget http://mirror.centos.org/centos/6/os/x86_64/Packages/mailx-12.4-8.el6_6.x86_64.rpm

wget http://mirror.centos.org/centos/6/os/x86_64/Packages/wsdl4j-1.5.2-7.8.el6.noarch.rpm

createrepo ..

Si Serengeti Management Server ne peut pas se connecter à Internet, vous devez exécuter les tâches

n

suivantes manuellement.

a Téléchargez les fichiers RPM comme indiqué dans l'exemple ci-dessous.

http://mirror.centos.org/centos/6/os/x86_64/Packages/mailx-12.4-8.el6_6.x86_64.rpm

http://mirror.centos.org/centos/6/os/x86_64/Packages/wsdl4j-1.5.2-7.8.el6.noarch.rpm

b Copiez les fichiers RPM dans /opt/serengeti/www/yum/repos/centos/6/base/RPMS/.

c Exécutez la commande createrepo pour créer un référentiel à partir des RPM que vous avez

téléchargés.

umask 022

chmod a+r /opt/serengeti/www/yum/repos/centos/6/base/*.rpm

createrepo /opt/serengeti/www/yum/repos/centos/6/base/

Installer le plug-in Big Data Extensions

Pour permettre à l'interface utilisateur Big Data Extensions d'être utilisée avec vCenter Server Web Client,

enregistrez le plug-in auprès de vSphere Web Client. L'interface utilisateur graphique Big Data Extensions

est uniquement prise en charge lorsque vous utilisez vSphere Web Client 5.5 et version ultérieure.

Le plug-in Big Data Extensions propose une interface graphique utilisateur qui s'intègre à

vSphere Web Client. À l'aide de l'interface du plug-in Big Data Extensions, vous pouvez effectuer des tâches

courantes de gestion de l'infrastructure Hadoop et de clusters.

REMARQUE Utilisez uniquement l'interface du plug-in Big Data Extensions dans vSphere Web Client ou le

client Serengeti CLI pour surveiller et gérer votre environnement Big Data Extensions. L'exécution

d'opérations de gestion dans vCenter Server risque d'entraîner une désynchronisation des outils de gestion

Big Data Extensions et leur incapacité à signaler correctement l'état de fonctionnement de votre

environnement Big Data Extensions.

Prérequis

Déployez le vApp Big Data Extensions. Reportez-vous à « Déployer le vApp Big Data Extensions dans

n

vSphere Web Client », page 23.

VMware, Inc. 27

Page 28

Guide de l'utilisateur et de l'administrateur VMware vSphere Big Data Extensions

Par défaut, le plug-in Web Big Data Extensions s'installe et s'enregistre automatiquement lors du

n

déploiement du vApp Big Data Extensions. Pour installer le plug-in Web Big Data Extensions après

avoir déployé le vApp Big Data Extensions, vous devez avoir choisi de ne pas activer l'enregistrement

automatique du plug-in Web pendant le déploiement. Reportez-vous à « Déployer le vApp Big Data

Extensions dans vSphere Web Client », page 23.

Assurez-vous de disposer d'informations d'identification de connexion avec des privilèges

n

d'administration pour le système vCenter Server pour lequel vous enregistrez Big Data Extensions.

REMARQUE Le nom d'utilisateur et le mot de passe que vous utilisez pour la connexion ne peuvent pas

contenir de caractères dont le codage UTF-8 est supérieur à 0x8000.

Si vous voulez utiliser l'adresse IP de vCenter Server pour accéder à vSphere Web Client et que votre

n

navigateur utilise un proxy, ajoutez l'adresse IP de vCenter Server à la liste des exceptions de proxy.

Procédure

1 Ouvrez un navigateur Web et accédez à l'URL de vSphere Web Client 5.5 ou version ultérieure.

https://hostname-or-ip-address:port/vsphere-client

La variable hostname-or-ip-address peut être le nom d'hôte DNS ou l'adresse IP de vCenter Server. Par

défaut, le port est 9443, mais il peut avoir changé au cours de l'installation de vSphere Web Client.

2 Entrez le nom d'utilisateur et le mot de passe avec des privilèges d'administration qui possèdent des

autorisations sur vCenter Server, puis cliquez sur Connexion.

3 À l'aide du volet de navigation vSphere Web Client, accédez au fichier ZIP sur

Serengeti Management Server qui contient le plug-in Big Data Extensions à enregistrer auprès de

vCenter Server.

Pour trouver Serengeti Management Server, recherchez sous le centre de données et le pool de

ressources dans lesquels il est déployé.

4 Dans l'arborescence de l'inventaire, sélectionnez management-server pour afficher des informations sur

Serengeti Management Server dans le volet central.

Cliquez sur l'onglet Résumé dans le volet central pour accéder à des informations supplémentaires.

5 Notez l'adresse IP de la machine virtuelle Serengeti Management Server.

6 Ouvrez un navigateur Web et accédez à l'URL de la machine virtuelle management-server.

https://management-server-ip-address:8443/register-plugin

La variable management-server-ip-address correspond à l'adresse IP que vous avez notée à l'étape Étape 5.

7 Entrez les informations pour enregistrer le plug-in.

Option Action

Enregistrer ou annuler

l'enregistrement

Nom d'hôte ou adresse IP de

vCenter Server

Nom utilisateur et Mot de passe

URL du package Big Data

Extensions

Cliquez sur Installer pour installer le plug-in. Sélectionnez Désinstaller

pour désinstaller le plug-in.

Entrez le nom d'hôte ou l'adresse IP de vCenter Server.

N'incluez pas http:// ni https:// quand vous entrez le nom d'hôte ou

l'adresse IP.

Entrez le nom d'utilisateur et le mot de passe avec des privilèges

d'administration que vous utilisez pour vous connecter à vCenter Server.

Le nom d'utilisateur et le mot de passe ne peuvent pas contenir de

caractères dont le codage UTF-8 est supérieur à 0x8000.

Entrez l'URL avec l'adresse IP de la machine virtuelle management-server

où se trouve le package du plug-in Big Data Extensions :

https://management-server-ip-address/vcplugin/serengetiplugin.zip

28 VMware, Inc.

Page 29

Chapitre 2 Installation de Big Data Extensions

8 Cliquez sur Soumettre.

Le plug-in Big Data Extensions s'enregistre auprès de vCenter Server et de vSphere Web Client.

9 Déconnectez-vous de vSphere Web Client, puis reconnectez-vous à l'aide de vos nom d'utilisateur et

mot de passe vCenter Server.

L'icône Big Data Extensions apparaît dans la liste des objets de l'inventaire.

10 Cliquez sur Big Data Extensions dans le volet Inventaire.

Suivant

Connectez le plug-in Big Data Extensions à l'instance Big Data Extensions que vous voulez gérer en vous

connectant au Serengeti Management Server correspondant. Reportez-vous à « Se connecter à un serveur de

gestion Serengeti », page 30.

Configurer les paramètres vCenter Single Sign-On du serveur de gestion Serengeti

Si les paramètres d'authentification Single Sign-On (SSO) Big Data Extensions ne sont pas configurés ou s'ils

ont changé suite à l'installation du plug-in Big Data Extensions, vous pouvez utiliser le portail

d'administration du serveur de gestion Serengeti pour activer SSO, mettre à jour le certificat et enregistrer le

plug-in pour pouvoir vous connecter au serveur de gestion Serengeti et continuer à gérer des clusters.

Le certificat SSL du plug-in Big Data Extensions peut changer pour de nombreuses raisons. Par exemple,

vous installez un certificat personnalisé ou remplacez un certificat qui a expiré.

Prérequis

Assurez-vous de connaître l'adresse IP du serveur de gestion Serengeti auquel vous voulez vous

n

connecter.

Assurez-vous de disposer des informations d'identification de connexion de l'utilisateur root du

n

serveur de gestion Serengeti.

Procédure

1 Ouvrez un navigateur Web et accédez à l'URL du portail d'administration du serveur de gestion

Serengeti.

https://management-server-ip-address:5480

2 Tapez root pour le nom d'utilisateur, tapez le mot de passe, puis cliquez sur Connexion.

3 Sélectionnez l'onglet SSO.

4 Effectuez l'une des opérations suivantes.

Option Description

Mettre à jour le certificat

Activer SSO pour la première fois

Cliquez sur Mettre à jour le certificat.

Tapez l'URL du service de recherche, puis cliquez sur Activer SSO.

Les certificats de serveur SSO Big Data Extensions et vCenter sont synchronisés.

Suivant

Enregistrez de nouveau le plug-in Big Data Extensions auprès du serveur de gestion Serengeti. Reportezvous à « Se connecter à un serveur de gestion Serengeti », page 30.

VMware, Inc. 29

Page 30

Guide de l'utilisateur et de l'administrateur VMware vSphere Big Data Extensions

Se connecter à un serveur de gestion Serengeti

Pour utiliser le plug-in Big Data Extensions pour gérer et surveiller des clusters Big Data et des distributions

Hadoop, vous devez connecter le plug-in Big Data Extensions au Serengeti Management Server dans votre

déploiement Big Data Extensions.

Vous pouvez déployer plusieurs instances du Serengeti Management Server dans votre environnement. En

revanche, vous ne pouvez connecter le plug-in Big Data Extensions qu'à une seule instance du serveur de

gestion Serengeti à la fois. Vous pouvez changer l'instance Serengeti Management Server à laquelle se

connecte le plug-in, puis utiliser l'interface du plug-in Big Data Extensions pour gérer et surveiller plusieurs

distributions Hadoop et HBase déployées dans votre environnement.

IMPORTANT Le Serengeti Management Server auquel vous vous connectez est partagé par tous les

utilisateurs de l'interface du plug-in Big Data Extensions dans vSphere Web Client. Si un utilisateur se

connecte à un autre Serengeti Management Server, tous les autres utilisateurs sont affectés par ce

changement.

Prérequis

Vérifiez que le déploiement du vApp Big Data Extensions s'est correctement déroulé et que la machine

n

virtuelle Serengeti Management Server est en cours d'exécution.

Vérifiez que la version du serveur de gestion Serengeti et du plug-in Big Data Extensions est la même.

n

Vérifiez que vCenter Single Sign-On est activé et configuré pour être utilisé par Big Data Extensions

n

pour vSphere 5.5 et versions ultérieures.

Installez le plug-in Big Data Extensions.

n

Procédure

1 Utilisez vSphere Web Client pour vous connecter à vCenter Server.

2 Sélectionnez Big Data Extensions.

3 Cliquez sur l'onglet Résumé.

4 Dans le volet Serveur connecté, cliquez sur le lien Connecter le serveur.

5 Accédez à la machine virtuelle du Serengeti Management Server dans le vApp Big Data Extensions

auquel se connecter, sélectionnez-la, puis cliquez sur OK.

Le plug-in Big Data Extensions communique via le protocole SSL avec le Serengeti Management Server.

Quand vous vous connectez à une instance du serveur Serengeti, le plug-in vérifie que le certificat SSL

en cours d'utilisation par le serveur est installé, valide et approuvé.

L'instance du serveur Serengeti apparaît en tant que serveur connecté sous l'onglet Résumé de la page

d'accueil Big Data Extensions.

Suivant

Vous pouvez ajouter un pool de ressources, une banque de données et des ressources réseau à votre

déploiement Big Data Extensions, puis créer des clusters Big Data que vous pouvez provisionner à des fins

d'utilisation.

30 VMware, Inc.

Page 31

Chapitre 2 Installation de Big Data Extensions

Installer le client d'interface de ligne de commande distant Serengeti

Bien que le plug-in Big Data Extensions pour vSphere Web Client prenne en charge des tâches de gestion de

ressources et de clusters basiques, vous pouvez exécuter bien plus de tâches de gestion à l'aide du client

Serengeti CLI.

Prérequis

Vérifiez que le déploiement du vApp Big Data Extensions s'est correctement déroulé et que le serveur

n

de gestion est en cours d'exécution.

Vérifiez que vous disposez du nom d'utilisateur et du mot de passe corrects pour vous connecter au

n

client Serengeti CLI. Si vous effectuez le déploiement sur vSphere 5.5 ou version ultérieure, le client

Serengeti CLI utilise vos informations d'identification vCenter Single Sign-On.

Vérifiez que l'environnement d'exécution Java (JRE, Java Runtime Environment) est installé dans votre

n

environnement et que son emplacement se trouve dans votre variable d'environnement PATH.

Procédure

1 Utilisez vSphere Web Client pour vous connecter à vCenter Server.

2 Sélectionnez Big Data Extensions.

3 Cliquez sur l'onglet Démarrage, puis sur le lien Télécharger la console d'interface de ligne de

commande Serengeti.

Un fichier ZIP contenant le client Serengeti CLI est téléchargé sur votre ordinateur.

4 Décompressez-le et examinez le téléchargement, qui inclut les composants suivants dans le répertoire

cli.

Fichier JAR serengeti-cli-version, qui inclut le client Serengeti CLI.

n

Répertoire samples, qui inclut des exemples de configurations de clusters.

n

Bibliothèques dans le répertoire lib.

n

5 Ouvrez une interface de commande, puis accédez au répertoire dans lequel vous avez décompressé le

package de téléchargement du client Serengeti CLI.

6 Accédez au répertoire cli, puis exécutez la commande suivante pour ouvrir le client Serengeti CLI :

java -jar serengeti-cli-version.jar

Suivant

Pour en savoir plus sur l'utilisation du client Serengeti CLI, consultez le Guide de l'interface de ligne de

commande VMware vSphere Big Data Extensions.

Accéder à l'interface de ligne de commande Serengeti à l'aide du client d'interface de ligne de commande distant

Vous pouvez accéder à l'interface de ligne de commande (CLI) Serengeti pour effectuer des tâches

administratives Serengeti à l'aide du client d'interface de ligne de commande distant Serengeti.

Prérequis

Utilisez VMware vSphere Web Client pour vous connecter au serveur VMware vCenter Server® sur

n

lequel vous avez déployé le vApp Serengeti.

Vérifiez que le déploiement de Serengeti vApp s'est correctement déroulé et que le serveur de gestion

n

est en cours d'exécution.

VMware, Inc. 31

Page 32

Guide de l'utilisateur et de l'administrateur VMware vSphere Big Data Extensions

Vérifiez que le mot de passe dont vous disposez pour vous connecter à la Serengeti CLI est exact.

n

Consultez le Guide de l'utilisateur et de l'administrateur VMware vSphere Big Data Extensions.

La Serengeti CLI utilise ses informations d'identification vCenter Server.

Vérifiez que l'environnement d'exécution Java (JRE, Java Runtime Environment) est installé dans votre

n

environnement et que son emplacement se trouve dans votre variable d'environnement path.

Procédure

1 Téléchargez le package Serengeti CLI à partir du Serengeti Management Server.

Ouvrez un navigateur Web et naviguez jusqu'à l'URL suivante :

https://server_ip_address/cli/VMware-Serengeti-CLI.zip

2 Téléchargez le fichier ZIP.

Le nom de fichier est au format VMware-Serengeti-cli-numéro_version-numéro_build.ZIP.

3 Décompressez le fichier téléchargé.

Celui-ci inclut les composants suivants.

Le fichier JAR serengeti-cli-version_number, qui inclut le Serengeti Remote CLI Client.

n

Répertoire samples, qui inclut des exemples de configurations de clusters.

n

Bibliothèques dans le répertoire lib.

n

4 Ouvrez une interface de commande, puis accédez au répertoire dans lequel vous avez décompressé le

package.

5 Accédez au répertoire cli, puis exécutez la commande suivante pour entrer dans l'interface de ligne de

commande Serengeti.

Pour les langues autres que le français ou l'allemand, exécutez la commande suivante.

n

java -jar serengeti-cli-numéro_version.jar

Pour le français ou l'allemand, qui utilisent l'encodage linguistique de page de code 850 (CP 850)

n

exécuter l'interface de ligne de commande Serengeti à partir d'une console de commandes

Windows, exécutez la commande suivante.

java -Dfile.encoding=cp850 -jar serengeti-cli-numéro_version.jar

6 Connectez-vous au service Serengeti.

Vous devez exécuter la commande connect host chaque fois que vous commencez une session

d'interface de ligne de commande, puis une nouvelle fois à l'issue du délai d'expiration de session de

30 minutes. Si vous n'exécutez pas cette commande, vous ne pouvez pas en exécuter d'autres.

a Exécutez la commande connect.

connect --host xx.xx.xx.xx:8443

b À l'invite, tapez votre nom d'utilisateur, qui peut être différent des informations d'identification

que vous utilisez pour vous connecter au Serengeti Management Server.

REMARQUE Si vous ne créez pas de nom d'utilisateur et de mot de passe pour le

Serengeti Command-Line Interface Client, vous pouvez utiliser les informations d'identification

d'administrateur vCenter Server par défaut. Le Serengeti Command-Line Interface Client utilise les

informations d'identification de vCenter Server avec les autorisations de lecture sur le

Serengeti Management Server.

c À l'invite, tapez votre mot de passe.

32 VMware, Inc.

Page 33

Chapitre 2 Installation de Big Data Extensions