Page 1

Stockage vSphere

Mise à jour 1

VMware vSphere 6.5

VMware ESXi 6.5

vCenter Server 6.5

Page 2

Stockage vSphere

Vous trouverez la documentation technique la plus récente sur le site Web de VMware à l'adresse :

hps://docs.vmware.com/fr/

Le site Web de VMware propose également les dernières mises à jour des produits.

N’hésitez pas à nous transmettre tous vos commentaires concernant cette documentation à l’adresse suivante :

docfeedback@vmware.com

Copyright © 2009–2017 VMware, Inc. Tous droits réservés. Copyright et informations sur les marques.

VMware, Inc.

3401 Hillview Ave.

Palo Alto, CA 94304

www.vmware.com

2 VMware, Inc.

VMware, Inc.

100-101 Quartier Boieldieu

92042 Paris La Défense

France

www.vmware.com/fr

Page 3

Table des matières

À propos de vSphere Storage 9

Introduction au stockage 11

1

Modèles de virtualisation de stockage traditionnels 11

Modèles de stockage à dénition logicielle 13

API de stockage vSphere 13

Mise en route d'un modèle de stockage traditionnel 15

2

Types de stockage physique 15

Adaptateurs de stockage pris en charge 25

Caractéristiques des banques de données 26

Présentation de l'utilisation d' ESXi avec un SAN 31

3

Cas d'utilisation d' ESXi et du SAN 32

Informations détaillées sur l'utilisation du stockage SAN avec l' ESXi 32

Hôtes ESXi et baies de stockage multiples 33

Prendre des décisions LUN 33

Sélection de l'emplacement des machines virtuelles 35

Applications de gestion tierces 35

Considérations sur la sauvegarde de stockage SAN 36

Utilisation d' ESXi avec un SAN Fibre Channel 39

4

Concepts du SAN Fibre Channel 39

Utilisation du zonage avec les SAN Fibre Channel 41

Accès des machines virtuelles aux données sur un SAN Fibre Channel 41

VMware, Inc.

Conguration du stockage Fibre Channel 43

5

Conditions requises de SAN Fibre Channel ESXi 43

Étapes d'installation et de conguration 45

Virtualisation d'identication N-Port 45

Conguration de Fibre Channel over Ethernet 49

6

Adaptateurs Fibre Channel over Ethernet 49

Instructions de conguration pour le FCoE logiciel 50

Congurer le réseau pour un adaptateur FCoE logiciel 50

Ajout d'adaptateurs FCoE du logiciel 51

Démarrage ESXi à partir du SAN Fibre Channel 53

7

Avantages du démarrage à partir d'un SAN 53

Exigences et considérations lors du démarrage à partir du SAN Fibre Channel 54

Préparation pour le démarrage à partir du SAN 54

3

Page 4

Stockage vSphere

Congurer Emulex HBA pour un démarrage à partir du SAN 56

Congurer QLogic HBA pour un démarrage à partir du SAN 57

Démarrage d' ESXi avec le FCoE logiciel 59

8

Considérations et exigences de démarrage du FCoE logiciel 59

Meilleures pratiques concernant le démarrage du FCoE logiciel 60

Congurer le démarrage du FCoE logiciel 60

Résolution des problèmes de démarrage à partir du FCoE logiciel pour un hôte ESXi 62

Meilleures pratiques pour le stockage Fibre Channel 63

9

Prévention des problèmes de SAN Fibre Channel 63

Désactiver l'enregistrement automatique de l'hôte 64

Optimisation des performances du stockage SAN Fibre Channel 64

Utilisation d' ESXi avec un SAN iSCSI 67

10

Concepts SAN iSCSI 67

Accès des machines virtuelles aux données sur un SAN iSCSI 72

Conguration des adaptateurs iSCSI et du stockage 75

11

Conditions du SAN ESXi iSCSI 76

ESXi iSCSI 76

Dénition des allocations de LUN pour iSCSI 76

Conguration de réseau et authentication 77

Congurer des adaptateurs de matériel iSCSI indépendants 77

À propos des adaptateurs de matériel iSCSI dépendants 81

À propos de l'adaptateur iSCSI logiciel 85

Modier les propriétés générales des adaptateurs iSCSI 88

Paramétrage du réseau iSCSI 89

Utilisation des trames Jumbo avec iSCSI 100

Conguration des adresses de découverte des adaptateurs iSCSI 101

Congurer des paramètres CHAP pour des adaptateurs iSCSI 102

Conguration des paramètres avancés iSCSI 106

Gestion des sessions iSCSI 108

Démarrage à partir du SAN iSCSI 111

12

Recommandations générales pour le démarrage à partir du SAN iSCSI 111

Préparation du SAN iSCSI 112

Congurer l'adaptateur iSCSI matériel indépendant pour le démarrage à partir du SAN 112

Présentation de iBFT iSCSI Boot 114

Meilleures pratiques pour le stockage iSCSI 121

13

Prévention des problèmes de iSCSI SAN 121

Optimisation des performances du stockage SAN iSCSI 122

Consultation des statistiques des commutateurs Ethernet 125

Gestion des périphériques de stockage 127

14

Caractéristiques du périphérique de stockage 127

Explication du nommage de périphériques de stockage 130

4 VMware, Inc.

Page 5

Table des matières

Opérations de réanalyse du stockage 132

Identication des problèmes de connectivité de périphérique 134

Modier les paramètres de chier de conguration 139

Activer ou désactiver le voyant voyants de localisateur sur les périphériques de stockage 140

Eacer des périphériques de stockage 140

Utilisation des périphériques Flash 143

15

Utilisation de périphériques Flash avec ESXi 144

Marquage de périphériques de stockage 145

Surveiller les périphériques Flash 146

Meilleures pratiques des périphériques Flash 146

À propos des ressources Virtual Flash 147

Conguration du cache d'échange d'hôte 150

À propos de VMware vSphere Flash Read Cache 153

16

Prise en charge du cache de lecture Flash par DRS 154

Prise en charge de Flash Read Cache par vSphere High Availability 154

Congurer Flash Read Cache pour une machine virtuelle 154

Migrer des machines virtuelles avec Flash Read Cache 155

Utilisation des banques de données 157

17

Types de banque de données 157

Présentation des banques de données VMFS 158

Présentation des banques de données NFS (Network File System) 168

Création de banques de données 179

Administration des banques de données VMFS dupliquées 183

Augmentation de la capacité d'une banque de données VMFS 185

Opérations administratives pour les banques de données 186

Conguration de la mise en miroir des disques dynamiques 194

Collecte d'informations de diagnostic pour les hôtes ESXi sur un périphérique de stockage 195

Vérication de la cohérence des métadonnées avec VOMA 198

Conguration du cache de blocs de pointage VMFS 200

Présentation de la gestion multivoie et du basculement 203

18

Basculements avec Fibre Channel 204

Basculement basé sur hôte avec iSCSI 204

Basculement à base de baie avec iSCSI 206

Basculement de chemin et machines virtuelles 207

Gestion des chemins multiples 208

Module de gestion multivoie de VMware 209

Analyse et réclamation des chemins 211

Gestion des chemins de stockage et des plug-ins chemins multiples 215

Files d'aente de planication pour les E/S de machines virtuelles 224

Mappage de périphérique brut 227

19

À propos du mappage de périphérique brut 227

Caractéristiques du mappage de périphérique brut 230

Création de machines virtuelles avec des RDM 232

VMware, Inc. 5

Page 6

Stockage vSphere

Gérer les chemins pour un LUN mappé 233

Stockage à dénition logicielle et gestion basée sur des stratégies de stockage 235

20

À propos de la gestion basée sur une stratégie de stockage (SPBM, Storage Policy Based

Management) 235

Stratégies de stockage de machine virtuelle 236

Utilisation de stratégies de stockage de machine virtuelle 236

Remplissage de l'interface des stratégies de stockage de machine virtuelle 237

Stratégies de stockage par défaut 241

Création et gestion de stratégies de stockage de machine virtuelle 243

Stratégies de stockage et machines virtuelles 254

Utilisation de fournisseurs de stockage 261

21

À propos des fournisseurs de stockage 261

Fournisseurs de stockage et représentation des données 262

Exigences et considérations relatives au fournisseur de stockage 263

Enregistrement des fournisseurs de stockage 263

Acher des informations sur le fournisseur de stockage 264

Annuler l'inscription des fournisseurs de stockage 265

Mere à jour les fournisseurs de stockage 265

Actualiser les certicats de fournisseurs de stockage 265

Utilisation de Virtual Volumes 267

22

À propos de Virtual Volumes 267

Concepts Virtual Volumes 268

Virtual Volumes et protocoles de stockage 273

Architecture de Virtual Volumes 274

Virtual Volumes et VMware Certicate Authority 275

Snapshots et Virtual Volumes 276

Avant d'activer Virtual Volumes 277

Congurer Virtual Volumes 278

Provisionner des machines virtuelles sur des banques de données Virtual Volumes 281

Virtual Volumes et réplication 285

Meilleures pratiques d'utilisation de vSphere Virtual Volumes 290

Filtrage des E/S de machines virtuelles 295

23

À propos des ltres d'E/S 295

Utilisation de périphériques de stockage Flash avec des ltres d'E/S de cache 298

Conguration système requise pour les ltres d'E/S 299

Congurer des ltres d'E/S dans l'environnement vSphere 300

Gestion des ltres d'E/S 305

Directives et meilleures pratiques applicables aux ltres d'E/S 306

Accélération matérielle du stockage 309

24

Avantages de l'accélération matérielle 309

Conditions requises pour l'accélération matérielle 310

État de la prise en charge de l'accélération matérielle 310

Accélération pour les périphériques de stockage de blocs 310

6 VMware, Inc.

Page 7

Accélération matérielle sur les périphériques NAS 315

Considérations sur l'accélération matérielle 318

Table des matières

Provisionnement dynamique et récupération d'espace 319

25

Provisionnement dynamique du disque virtuel 319

ESXi et provisionnement dynamique de la baie 324

Récupération d'espace de stockage 326

Utilisation de vmkfstools 333

26

Syntaxe des commandes vmkfstools 333

Options de la commande vmkfstools 334

Index 345

VMware, Inc. 7

Page 8

Stockage vSphere

8 VMware, Inc.

Page 9

À propos de vSphere Storage

vSphere Storage décrit les technologies de stockage dénies par logiciel et virtualisées que VMware ESXi™ et

VMware vCenter Server® orent et explique comment congurer et utiliser ces technologies.

Public cible

Ces informations s'adressent aux administrateurs système expérimentés qui maîtrisent les technologies de

machine virtuelle et de virtualisation de stockage, les opérations associées aux centres de données et les

concepts de stockage SAN.

vSphere Web Client et vSphere Client

Les instructions relatives aux tâches présentées dans ce guide se basent sur vSphere Web Client. Vous

pouvez également exécuter la plupart des tâches de ce guide en utilisant la nouvelle version de

vSphere Client. La terminologie, la topologie et le workow de la nouvelle interface utilisateur de

vSphere Clientcorrespondent dèlement aux aspects et éléments de l'interface utilisateur de

vSphere Web Client. Vous pouvez appliquer les instructions de vSphere Web Client à la nouvelle version de

vSphere Client sauf mention du contraire.

R Les fonctionnalités de vSphere Web Client n'ont pas toutes été mises en œuvre pour

vSphere Client dans la version vSphere 6.5. Pour obtenir une liste actualisée des fonctionnalités non prises

en charge, consultez le Guide des mises à jour des fonctionnalités de vSphere Client sur

hp://www.vmware.com/info?id=1413.

VMware, Inc.

9

Page 10

Stockage vSphere

10 VMware, Inc.

Page 11

Introduction au stockage 1

vSphere prend en charge diverses fonctionnalités et options de stockage dans des environnements de

stockage traditionnels et logiciels. Une présentation de haut niveau des éléments et aspects du stockage

vSphere vous permet de planier une stratégie de stockage appropriée pour votre centre de données virtuel.

Ce chapitre aborde les rubriques suivantes :

« Modèles de virtualisation de stockage traditionnels », page 11

n

« Modèles de stockage à dénition logicielle », page 13

n

« API de stockage vSphere », page 13

n

Modèles de virtualisation de stockage traditionnels

En règle générale, la virtualisation de stockage se rapporte à une abstraction logique de ressources de

stockage physique et de capacités à partir des machines virtuelles et de leurs applications. ESXi ore la

virtualisation de stockage au niveau de l'hôte.

Dans l'environnement vSphere , un modèle traditionnel repose sur les technologies de stockage ainsi que

sur les fonctionnalités de virtualisation ESXi et vCenter Server suivantes.

Stockage local et en

réseau

Réseaux de zone de

stockage

Fibre Channel

Dans les environnements de stockage traditionnels, le processus de gestion

de stockage d'ESXi débute avec l'espace de stockage préalloué par votre

administrateur stockage sur diérents systèmes de stockage. ESXi prend en

charge le stockage local et en réseau.

Reportez-vous à « Types de stockage physique », page 15.

Un réseau de zone de stockage (SAN) est un réseau à haute vitesse spécialisé

qui connecte des systèmes informatiques, ou des hôtes ESXi, à des systèmes

de stockage à hautes performances. L'ESXi peut utiliser les protocoles Fibre

Channel ou iSCSI pour se connecter aux systèmes de stockage.

Reportez-vous à Chapitre 3, « Présentation de l'utilisation d'ESXi avec un

SAN », page 31.

Fibre Channel (FC) est un protocole de stockage que le SAN utilise pour

transférer le trac de données des serveurs d'hôtes ESXi au stockage partagé.

Le protocole conditionne les commandes SCSI en trames FC. Pour se

connecter au SAN FC, votre hôte utilise des adaptateurs de bus hôte (HBA)

Fibre Channel.

Reportez-vous à Chapitre 4, « Utilisation d'ESXi avec un SAN Fibre

Channel », page 39.

VMware, Inc. 11

Page 12

Stockage vSphere

Internet SCSI

Périphérique de

stockage ou LUN

Disques virtuels

Internet iSCSI (iSCSI) est un protocole de transport SAN qui peut utiliser des

connexions Ethernet entre les systèmes informatiques, ou les hôtes ESXi, et

les systèmes de stockage à hautes performances. Pour vous connecter aux

systèmes de stockage, vos hôtes utilisent des adaptateurs iSCSI matériels ou

des initiateurs iSCSI logiciels avec des adaptateurs réseau standard.

Reportez-vous à Chapitre 10, « Utilisation d'ESXi avec un SAN iSCSI »,

page 67.

Dans le contexte de l'ESXi, les termes « périphérique » et « LUN » sont

utilisés de façon interchangeable. En général, les deux termes signient un

volume de stockage qui est présenté à l'hôte à partir d'un système de

stockage des blocs et qui est disponible pour le formatage.

Reportez-vous aux sections « Représentations de périphériques et de cibles »,

page 20 et Chapitre 14, « Gestion des périphériques de stockage », page 127.

Une machine virtuelle sur un hôte ESXi utilise un disque virtuel pour stocker

son système d'exploitation, les chiers d'applications et d'autres données

liées à ses activités. Les disques virtuels sont des chiers physiques

volumineux, ou des ensembles de chiers, qui peuvent être copiés, déplacés,

archivés et sauvegardés comme n'importe quel autre chier. Vous pouvez

congurer les machines virtuelles avec plusieurs disques virtuels.

Pour accéder à des disques virtuels, une machine virtuelle utilise les

contrôleurs SCSI virtuels. Ces contrôleurs virtuels sont notamment BusLogic

Parallel, LSI Logic Parallel, LSI Logic SAS, et VMware Paravirtual. Ces

contrôleurs sont les seuls types de contrôleurs SCSI visibles et accessibles par

une machine virtuelle.

Chaque disque virtuel réside sur une banque de données qui est déployée

sur un stockage physique. Du point de vue de la machine virtuelle, chaque

disque virtuel apparaît comme un lecteur SCSI connecté à un contrôleur

SCSI. Que le stockage physique soit accessible via des adaptateurs de

stockage ou des adaptateurs réseau sur l'hôte, il est généralement transparent

pour le système d'exploitation invité et les applications sur la machine

virtuelle.

VMware vSphere® VMFS

Les banques de données que vous déployez sur des périphériques de

stockage des blocs utilise le format VMFS (vSphere Virtual Machine File

System) natif. Il s'agit d'un format de système de chiers haute performance

qui est optimisé pour stocker les machines virtuelles.

Reportez-vous à « Présentation des banques de données VMFS », page 158.

NFS

Un client NFS intégré dans ESXi utilise le protocole NFS (Network File

System) sur TCP/IP pour accéder à un volume NFS qui se trouve sur un

serveur NAS. L'hôte ESXi peut monter le volume et l'utiliser comme une

banque de données NFS.

Reportez-vous à « Présentation des banques de données NFS (Network File

System) », page 168.

Mappage de

périphérique brut

En plus des disques virtuels, vSphere propose un mécanisme appelé

mappage de périphérique brut (RDM). Le RDM est utile lorsqu'un système

d'exploitation invité dans une machine virtuelle requiert un accès direct à un

périphérique de stockage. Pour plus d'informations sur les RDM, consultez

Chapitre 19, « Mappage de périphérique brut », page 227.

12 VMware, Inc.

Page 13

Modèles de stockage à définition logicielle

Outre l’abstraction des capacités de stockage sous-jacentes des machines virtuelles, à l’instar des modèles de

stockage traditionnels, le stockage déni par le logiciel crée une abstraction des capacités de stockage.

Avec le modèle de stockage à dénition logicielle, une machine virtuelle devient une unité de

provisionnement de stockage et peut être gérée au moyen d'un mécanisme exible basé sur la stratégie. Le

modèle implique les technologies vSphere suivantes.

Chapitre 1 Introduction au stockage

Gestion basée sur des

stratégies de stockage

(SPBM, Storage Policy

Based Management)

VMware vSphere

Virtual Volumes™

VMware vSAN

Filtres d'E/S

®

SPBM est une infrastructure qui fournit un seul panneau entre les diérents

services de données et les solutions de stockage, notamment vSAN et Virtual

Volumes. À l'aide des stratégies de stockage, l'infrastructure aligne les

demandes d'applications de vos machines virtuelles avec les fonctionnalités

proposées par les entités de stockage.

Reportez-vous à Chapitre 20, « Stockage à dénition logicielle et gestion

basée sur des stratégies de stockage », page 235.

La fonctionnalité Virtual Volumes modie le paradigme de gestion du

stockage de la gestion de l'espace au sein de banques de données à la gestion

d'objets de stockage abstraits par des baies de stockage. Avec Virtual

Volumes, une machine virtuelle individuelle, pas la banque de données,

devient une unité de gestion de stockage. Par ailleurs, le matériel de stockage

possède le contrôle complet sur le contenu, l'architecture et la gestion des

disques virtuels.

Reportez-vous à Chapitre 22, « Utilisation de Virtual Volumes », page 267.

vSAN est une couche distribuée de logiciel qui s'exécute nativement en tant

que partie de l'hyperviseur. vSAN cumule des périphériques de capacité

locaux ou à connexion directe d'un cluster hôte ESXi et crée un pool de

stockage unique partagé sur tous les hôtes du cluster vSAN.

Reportez-vous à Administration de VMware vSAN.

Les ltres d'E/S sont des composants logiciels pouvant être installés sur les

hôtes ESXi et orir des services de données supplémentaires aux machines

virtuelles. En fonction de la mise en œuvre, les services peuvent inclure la

réplication, le chirement, la mise en cache, etc.

Reportez-vous à Chapitre 23, « Filtrage des E/S de machines virtuelles »,

page 295.

API de stockage vSphere

Les API de stockage représentent une famille d'API utilisée par des fournisseurs tiers de matériels, de

logiciels et de stockage pour développer des composants qui améliorent plusieurs fonctionnalités et

solutions de vSphere.

Cee publication de stockage décrit plusieurs API de stockage qui constituent votre environnement de

stockage. Pour plus d'informations sur d'autres API de cee famille, notamment vSphere APIs - Data

Protection, rendez-vous sur le site Web de VMware.

VMware, Inc. 13

Page 14

Stockage vSphere

VASA (vSphere APIs for Storage Awareness)

Les API VASA, proposées par des distributeurs tiers ou par VMware, permeent les communications entre

vCenter Server et le stockage sous-jacent. Via VASA, les entités de stockage peuvent indiquer à vCenter

Server leurs congurations, leurs capacités, ainsi que des informations concernant la santé et les événements

de stockage. En retour, VASA peut transmere des conditions requises de stockage de machine virtuelle

depuis vCenter Server vers une entité de stockage et ainsi garantir que la couche de stockage répond aux

conditions requises.

VASA devient essentiel lorsque vous utilisez Virtual Volumes, vSAN, VAIO (vSphere APIs for I/O Filtering)

et des stratégies de stockage de machine virtuelle. Reportez-vous à Chapitre 21, « Utilisation de fournisseurs

de stockage », page 261.

VAAI (vSphere APIs for Array Integration)

Les API VAAI incluent les composants suivants :

API d'accélération matérielle. Permet aux baies de s'intégrer à vSphere an que vSphere puisse

n

décharger certaines opérations de stockage sur la baie. Cee intégration réduit considérablement la

surcharge du CPU sur l'hôte. Reportez-vous à Chapitre 24, « Accélération matérielle du stockage »,

page 309.

API à provisionnement dynamique de la baie. Permet de surveiller l'utilisation de l'espace sur les baies

n

de stockage à provisionnement dynamique pour empêcher des conditions de manque d'espace et pour

eectuer une réclamation d'espace. Reportez-vous à « ESXi et provisionnement dynamique de la baie »,

page 324.

API vSphere pour gestion de chemins multiples

Connues sous l'appellation PSA (Pluggable Storage Architecture), ces API permeent aux partenaires de

stockage de créer et de fournir des plug-ins de gestion de chemins multiples et d'équilibrage de charge

optimisés pour chaque baie. Les plug-ins communiquent avec les baies de stockage et déterminent la

meilleure stratégie de sélection de chemins pour augmenter les performances d'E/S et la abilité de l'hôte

ESXi vers la baie de stockage. Pour plus d'informations, consultez « Gestion des chemins multiples »,

page 208.

14 VMware, Inc.

Page 15

Mise en route d'un modèle de

stockage traditionnel 2

La conguration de votre stockage ESXi dans les environnements traditionnels comprend la conguration

des systèmes et périphériques de stockage, l'activation des adaptateurs de stockage et la création de banques

de données.

Ce chapitre aborde les rubriques suivantes :

« Types de stockage physique », page 15

n

« Adaptateurs de stockage pris en charge », page 25

n

« Caractéristiques des banques de données », page 26

n

Types de stockage physique

Dans les environnements de stockage traditionnels, le processus de gestion de stockage d'ESXi débute avec

l'espace de stockage préalloué par votre administrateur stockage sur diérents systèmes de stockage. ESXi

prend en charge le stockage local et en réseau.

Stockage local

Le stockage local peut se composer de disques durs internes situés à l'intérieur de votre hôte ESXi. Il peut

également inclure des systèmes de stockage externes situés à l'extérieur et connectés directement à l'hôte par

le biais de protocoles tels que SAS ou SATA.

Le stockage local ne requiert pas de réseau de stockage pour communiquer avec votre hôte. Vous avez

besoin d'un câble connecté à l'unité de stockage et, si nécessaire, d'un HBA compatible dans votre hôte.

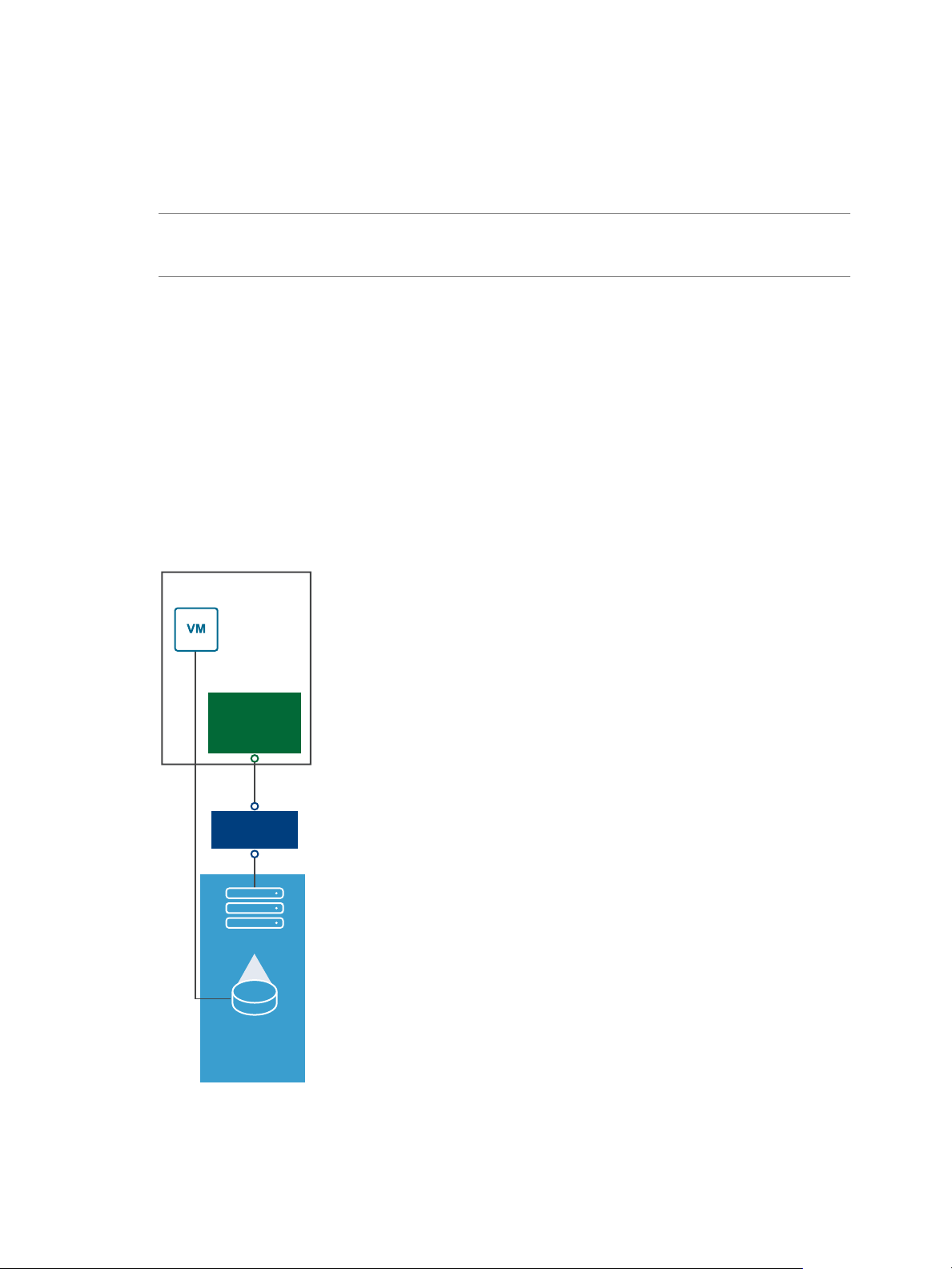

L'illustration suivante décrit une machine virtuelle utilisant un stockage SCSI local.

VMware, Inc.

15

Page 16

Hôte ESXi

vmdk

Périphérique

VMFS

SCSI

Stockage vSphere

Figure 2‑1. Stockage local

Dans cet exemple de topologie de stockage local, l'hôte ESXi utilise une connexion unique à un périphérique

de stockage. Sur ce périphérique, vous pouvez créer une banque de données VMFS que vous utilisez pour

stocker les chiers de disque de la machine virtuelle.

Bien que cee conguration de stockage soit possible, elle n'est pas recommandée. L'utilisation de

connexions uniques entre des périphériques de stockage et des hôtes crée des points de défaillance uniques

(SPOF) pouvant causer des interruptions lorsqu'une connexion devient instable ou échoue. Toutefois,

puisque la plupart des périphériques de stockage local ne prennent pas en charge les connexions multiples,

vous ne pouvez pas utiliser plusieurs chemins d'accès pour accéder au stockage local.

ESXi prend en charge divers périphériques de stockage local, notamment les systèmes de stockage SAS,

SCSI, IDE, SATA et USB. Quel que soit le type de stockage utilisé, votre hôte masque une couche de stockage

physique aux machines virtuelles.

R Vous ne pouvez pas utiliser de lecteurs IDE/ATA ou USB pour stocker des machines virtuelles.

Le stockage local ne prend pas en charge le partage sur plusieurs hôtes. Seul un hôte peut accéder à une

banque de données sur un périphérique de stockage local. Par conséquent, bien que vous puissiez utiliser un

stockage local pour créer des machines virtuelles, vous ne pouvez pas utiliser les fonctionnalités de VMware

qui exigent un stockage partagé, telles que HA et vMotion.

Cependant, si vous utilisez un cluster d'hôtes disposant uniquement de périphériques de stockage local,

vous pouvez implémenter vSAN. vSAN transforme des ressources de stockage locales en stockage partagé

déni par logiciel. Avec vSAN, vous pouvez utiliser des fonctionnalités qui exigent un stockage partagé.

Pour plus d'informations, voir la documentation Administration de VMware vSAN.

Stockage en réseau

Le stockage en réseau est composé de systèmes de stockage externes que votre hôte ESXi utilise pour stocker

des chiers de machine virtuelle à distance. En règle générale, l'hôte accède à ces systèmes sur un réseau de

stockage haut-débit.

Les périphériques de stockage en réseau sont partagés. Les banques de données sur des périphériques de

stockage en réseau sont accessibles par plusieurs hôtes simultanément. ESXi prend en charge plusieurs

technologies de stockage en réseau.

16 VMware, Inc.

Page 17

Hôte ESXi

vmdk

Baie

Fibre Channel

VMFS

SAN

HBA

Fibre

Channel

Chapitre 2 Mise en route d'un modèle de stockage traditionnel

Outre le stockage en réseau traditionnel abordé dans cee rubrique, VMware prend en charge les

technologies de stockage partagé virtualisé telles que vSAN. vSAN transforme les ressources de stockage

internes de vos hôtes ESXi en stockage partagé qui fournit des fonctionnalités telles que High Availability et

vMotion aux machines virtuelles. Pour plus d'informations, voir la documentation Administration de VMware

vSAN.

R Un même LUN ne peut pas être présenté à un hôte ESXi ou à plusieurs hôtes via diérents

protocoles de stockage. Pour accéder au LUN, les hôtes doivent toujours utiliser un seul protocole, par

exemple uniquement Fibre Channel ou uniquement iSCSI.

Fibre Channel (FC)

Stocke des chiers de machine virtuelle à distance sur un réseau de zone de stockage FC (SAN). FC SAN est

un réseau haut débit spécialisé qui connecte vos hôtes à des périphériques de stockage haute performance.

Le réseau utilise le protocole Fibre Channel pour acheminer le trac SCSI depuis des machines virtuelles

vers des périphériques FC SAN.

Pour se connecter au FC SAN, votre hôte doit être équipé d'adaptateurs de bus hôte (HBA) Fibre Channel. À

moins d'utiliser un stockage de connexion directe Fibre Channel, vous avez besoin de commutateurs Fibre

Channel pour acheminer le trac de stockage. Si votre hôte contient des adaptateurs FCoE (Fibre Channel

over Ethernet), vous pouvez vous connecter à vos périphériques Fibre Channel partagés à l'aide d'un réseau

Ethernet.

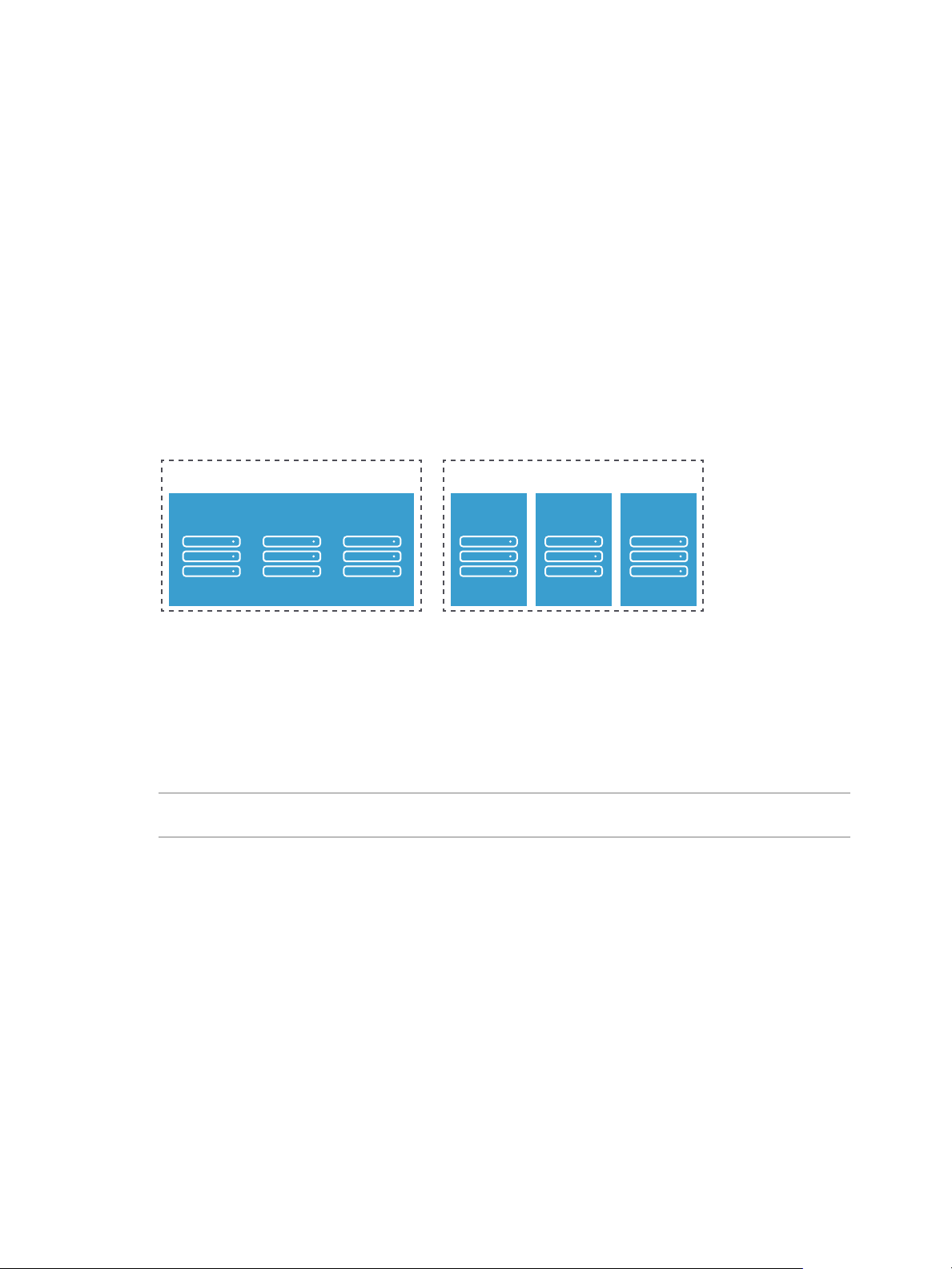

Stockage Fibre Channel décrit les machines virtuelles utilisant le stockage Fibre Channel.

Figure 2‑2. Stockage Fibre Channel

VMware, Inc. 17

Page 18

Baie iSCSI

VMFS VMFS

LAN LAN

HBA

iSCSI

Carte réseau

Ethernet

Hôte ESXi

Adaptateur

logiciel

vmdk vmdk

Stockage vSphere

Dans cee conguration, un hôte se connecte à une infrastructure SAN, qui est constituée de commutateurs

Fibre Channel et de baies de stockage, en utilisant un adaptateur Fibre Channel. Les LUN d'une baie de

stockage deviennent disponibles pour l'hôte. Vous pouvez accéder aux LUN et créer des banques de

données pour vos besoins de stockage. Les banques de données utilisent le format VMFS.

Pour plus d'informations spéciques sur la conguration du SAN Fibre Channel, consultez Chapitre 4,

« Utilisation d'ESXi avec un SAN Fibre Channel », page 39.

Internet SCSI (iSCSI)

Stocke des chiers de machine virtuelle sur des périphériques de stockage iSCSI à distance. iSCSI rassemble

le trac de stockage SCSI dans le protocole TCP/IP, de sorte qu'il puisse être acheminé via des réseaux

TCP/IP standard et non le réseau FC spécialisé. Grâce à une connexion iSCSI, votre hôte sert d'initiateur qui

communique avec une cible, située dans des systèmes de stockage iSCSI à distance.

ESXi ore les types de connexions iSCSI suivants :

iSCSI matériel

Votre hôte se connecte au stockage via un adaptateur tiers capable de

décharger la gestion de réseau et iSCSI. Les adaptateurs matériels peuvent

être dépendants et indépendants.

iSCSI logiciel

Votre hôte utilise un initiateur iSCSI logiciel dans le VMkernel pour se

connecter au stockage. Avec ce type de connexion iSCSI, votre hôte ne

requiert qu'un adaptateur réseau standard pour la connectivité réseau.

Vous devez congurer les initiateurs iSCSI de l'hôte pour qu'il accède et ache les périphériques de

stockage iSCSI.

Le stockage iSCSI décrit diérents types d'initiateurs iSCSI.

Figure 2‑3. Stockage iSCSI

Dans l'exemple de gauche, l'hôte utilise l'adaptateur iSCSI matériel pour se connecter au système de

18 VMware, Inc.

stockage iSCSI.

Page 19

Hôte ESXi

Dispositif

NAS

vmdk

NFS

LAN

Carte réseau

Ethernet

Chapitre 2 Mise en route d'un modèle de stockage traditionnel

Dans l'exemple de droite, l'hôte utilise un adaptateur iSCSI logiciel et un adaptateur d'interface réseau

Ethernet pour se connecter au stockage iSCSI.

Les périphériques de stockage iSCSI du système de stockage deviennent disponibles pour l'hôte. Vous

pouvez accéder aux périphériques de stockage et créer des banques de données VMFS pour vos besoins de

stockage.

Pour plus d'informations spéciques sur la conguration du SAN iSCSI, consultez Chapitre 10, « Utilisation

d'ESXi avec un SAN iSCSI », page 67.

Stockage relié au réseau (NAS)

Stocke les chiers de machine virtuelle sur des serveurs de chiers à distance accessibles sur un réseau

TCP/IP standard. Le client NFS intégré dans ESXi utilise le protocole NFS (Network File System) versions 3

et 4.1 pour communiquer avec les serveurs NAS/NFS. Pour une connectivité réseau, l'hôte requiert un

adaptateur réseau standard.

Vous pouvez monter un volume NFS directement sur l'hôte ESXi. Vous utilisez ensuite des banques de

données NFS pour stocker et gérer des machines virtuelles de la même manière que vous utilisez des

banques de données VMFS.

Stockage NFS décrit une machine virtuelle utilisant la banque de données NFS pour stocker ses chiers.

Dans cee conguration, l'hôte se connecte au serveur NAS stockant les chiers du disque virtuel via un

adaptateur réseau normale.

Figure 2‑4. Stockage NFS

Pour des informations spéciques sur la conguration du stockage NFS, consultez « Présentation des

banques de données NFS (Network File System) », page 168.

VMware, Inc. 19

Page 20

Baie de stockage

Cible

LUN LUN LUN

Baie de stockage

Cible CibleCible

LUN LUN LUN

Stockage vSphere

SAS (Serial Attached SCSI) partagé

Stocke des machines virtuelles sur des systèmes de stockage directement reliés au SAS qui orent un accès

partagé à plusieurs hôtes. Ce type d'accès permet à plusieurs hôtes d'accéder à la même banque de données

VFMS sur un LUN.

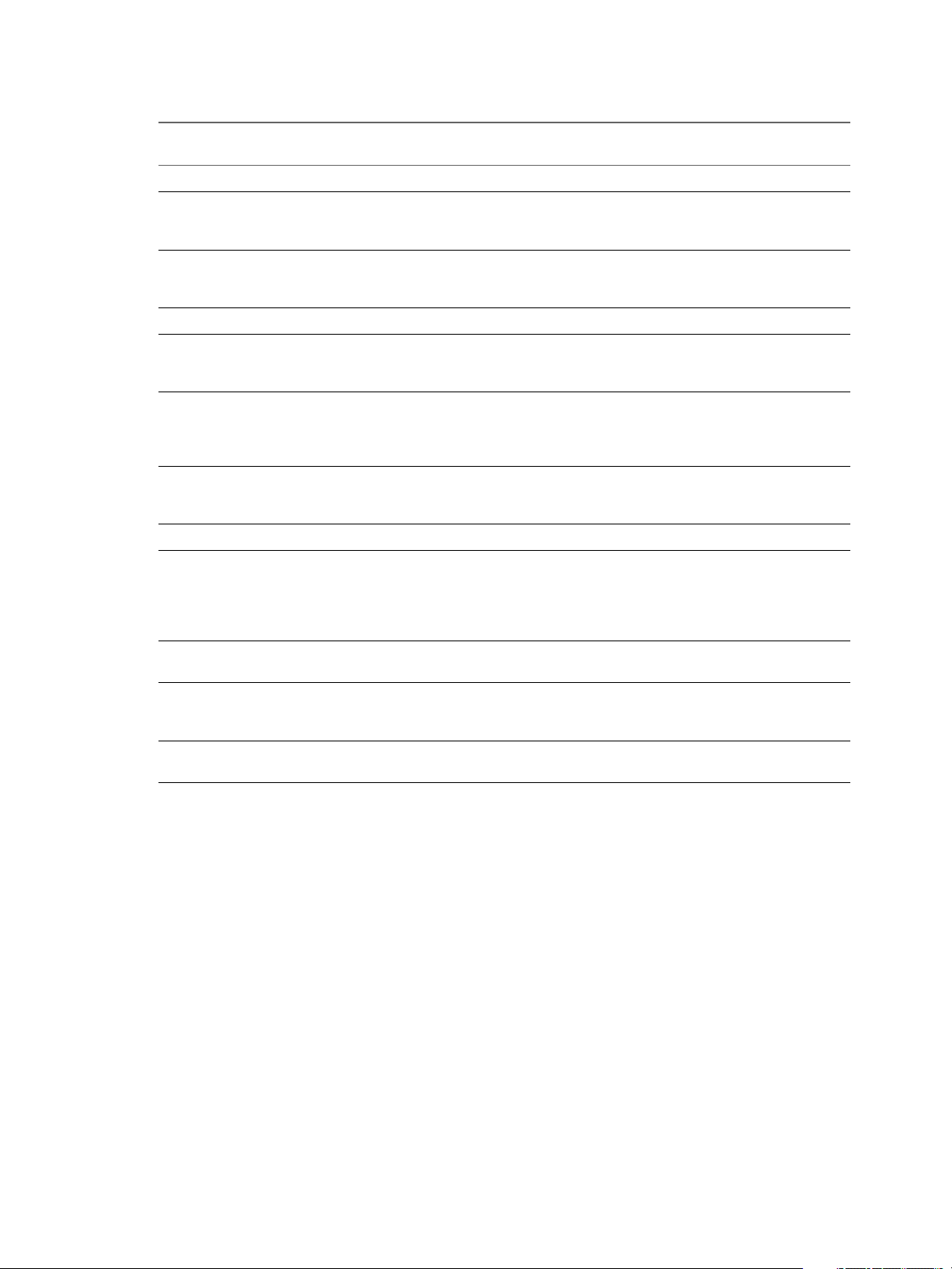

Représentations de périphériques et de cibles

Dans un contexte ESXi, le terme cible identie une unité de stockage unique accessible par l'hôte. Les termes

périphérique de stockage et LUN décrivent un volume logique représentant l'espace de stockage sur une

cible. Dans le contexte ESXi, les deux termes signient également un volume de stockage présenté à l'hôte à

partir d'une unité de stockage cible et disponible pour le formatage. Périphérique de stockage et LUN sont

souvent interchangeables.

Diérents fournisseurs de stockage présentent les systèmes de stockage pour les hôtes ESXi de diérentes

manières. Certains fournisseurs présentent une cible unique comportant plusieurs LUN ou périphériques de

stockage, tandis que d'autres proposent plusieurs cibles disposant chacune d'un LUN.

Figure 2‑5. Représentations LUN et de cibles

Dans cee illustration, trois LUN sont disponibles pour chaque conguration. Dans un cas, l'hôte se

connecte à une cible, mais cee cible comporte trois LUN à utiliser. Chaque LUN représente un volume de

stockage individuel. Dans l'autre exemple, l'hôte détecte trois cibles diérentes, chacune disposant d'un

LUN.

Les cibles accessibles via le réseau ont des noms uniques fournis par les systèmes de stockage. Les cibles

iSCSI utilisent des noms iSCSI, alors que les cibles Fibre Channel utilisent des noms mondiaux dits Noms

mondiaux (WWN).

R ESXi ne prend pas en charge l'accès au même LUN via diérents protocoles de transport, tels

que iSCSI et Fibre Channel.

Un périphérique, ou LUN, est identié par son nom UUID. Si un LUN est partagé par plusieurs hôtes, il doit

être présenté à tous les hôtes ayant le même UUID.

Accès des machines virtuelles au stockage

Lorsqu'une machine virtuelle communique avec son disque virtuel stocké sur une banque de données, elle

lance des commandes SCSI. Étant donné que les banques de données peuvent résider sur plusieurs types de

stockage physique, ces commandes sont encapsulées dans d'autres formes, selon le protocole utilisé par

l'hôte ESXi pour se connecter à un périphérique de stockage.

ESXi prend en charge les protocoles Fibre Channel (FC), Internet SCSI (iSCSI), Fibre Channel over Ethernet

(FCoE) et NFS. Quel que soit le type de périphérique de stockage utilisé par votre hôte, le disque virtuel

apparaît toujours en tant que périphérique SCSI monté pour la machine virtuelle. Le disque virtuel masque

une couche de stockage physique au système d'exploitation de la machine virtuelle. Cee action permet

d'exécuter des systèmes d'exploitation non certiés pour un équipement de stockage spécique, tel que

SAN, dans une machine virtuelle.

20 VMware, Inc.

Page 21

Baie iSCSI

VMFS VMFS

LAN LAN

HBA

iSCSI

Carte réseau

Ethernet

Hôte ESXi

Requiert une connectivité TCP/IP

Adaptateur

logiciel

iSCSI

Dispositif

NAS

NFS

LAN

Carte réseau

Ethernet

Groupe

Fibre Channel

VMFS

VMFS

vmdk

vmdk vmdk vmdk vmdk

SAN

HBA

Fibre

Channel

Périphérique

SCSI

Chapitre 2 Mise en route d'un modèle de stockage traditionnel

L'illustration suivante décrit cinq machines virtuelles utilisant diérents types de stockage an d'illustrer

leurs diérences.

Figure 2‑6. Machines virtuelles accédant à différents types de stockage

R Ce diagramme est uniquement destiné à des ns conceptuelles. Ce n'est pas une conguration

recommandée.

Caractéristiques du périphérique de stockage

Lorsque votre hôte ESXi se connecte aux systèmes de stockage basés sur des blocs, les LUN ou les

périphériques de stockage prenant en charge l'ESXi deviennent disponibles pour l'hôte. Vous pouvez

acher tous les périphériques de stockage, notamment tous les périphériques locaux et en réseau. Si vous

utilisez des plug-ins chemins multiples tiers, les périphériques de stockage disponibles via les plug-ins

apparaissent également dans la liste.

Pour chaque adaptateur de stockage, vous pouvez acher une liste distincte de périphériques de stockage

disponibles pour cet adaptateur.

En règle générale, lorsque vous consultez les périphériques de stockages, vous voyez les informations

suivantes.

Tableau 2‑1. Informations du périphérique de stockage

Informations du

périphérique de stockage Description

Nom Appelé également Nom d'achage. C'est un nom que l'hôte ESXi aecte à un

Identicateur Identicateur universel unique intrinsèque au périphérique.

État opérationnel Indique si le périphérique est aaché ou détaché. Pour des détails, veuillez vous

LUN LUN (Logical Unit Number) à l'intérieur de la cible SCSI. Le numéro de LUN est fourni

périphérique selon le type de stockage et le fabricant. Vous pouvez changer ce nom par

le nom de votre choix.

reporter à la section « Déconnexion des périphériques de stockage », page 136.

par le système de stockage. Si une cible possède un seul LUN, le numéro de LUN est

toujours zéro (0).

VMware, Inc. 21

Page 22

Stockage vSphere

Tableau 2‑1. Informations du périphérique de stockage (suite)

Informations du

périphérique de stockage Description

Type Type de périphérique, par exemple, disque ou CD-ROM.

Type de lecteur Informations précisant si le périphérique est en lecteur Flash ou un simple disque dur.

Transport Protocole de transport utilisé par votre hôte pour accéder au périphérique. Le protocole

Capacité Capacité totale du périphérique de stockage.

Propriétaire Le plug-in, tel que le NMP ou un plug-in tiers, que l'hôte utilise pour gérer les chemins

Accélération matérielle Informations indiquant que le périphérique de stockage assiste l'hôte avec des

Format de secteur Indique si le périphérique utilise un format de secteur traditionnel, 512n ou avancé, tel

Emplacement

Format de partition Un système de partition utilisé par le périphérique de stockage. Ce peut être un format

Partitions Partitions logiques et principales, y compris une banque de données VMFS, si

Stratégies de chemins

multiples (banques de

données VMFS)

Chemins (banques de données

VMFS)

Pour obtenir des informations sur les lecteurs Flash, reportez-vous à Chapitre 15,

« Utilisation des périphériques Flash », page 143.

dépend du type de stockage utilisé. Reportez-vous à « Types de stockage physique »,

page 15.

vers le périphérique de stockage. Pour des détails, veuillez vous reporter à la section

« Gestion des chemins multiples », page 208.

opérations de gestion de machine virtuelle. L'état peut être Pris en charge, Non pris en

charge ou Inconnu. Pour des détails, veuillez vous reporter à la section Chapitre 24,

« Accélération matérielle du stockage », page 309.

que 512e. Pour plus d'informations, consultez « Formats de périphérique de stockage et

banques de données VMFS », page 161.

Chemin d'accès au périphérique de stockage dans l'inventaire /vmfs/devices/.

MBR (master boot record) ou un format GPT (GUID partition table). Les périphériques

GPT peuvent prendre en charge des banques de données d'une taille supérieure à 2 To.

Pour plus d'informations, consultez « Formats de périphérique de stockage et banques

de données VMFS », page 161.

congurée.

Règle de sélection de chemin et règle de type de baie de stockage utilisées par l'hôte

pour gérer les chemins de stockage. Pour plus d'informations, consultez Chapitre 18,

« Présentation de la gestion multivoie et du basculement », page 203.

Chemins utilisés pour accéder au stockage et leur état.

Affichage des périphériques de stockage d'un hôte

Acher tous les périphériques de stockage disponibles pour un hôte. Si vous utilisez des plug-ins chemins

multiples tiers, les périphériques de stockage disponibles via les plug-ins apparaissent également dans la

liste.

La vue Périphériques de stockage vous permet de répertorier les périphériques de stockage des hôtes,

d'analyser leurs informations et de modier leurs propriétés.

Procédure

1 Accédez à l'hôte dans le navigateur de vSphere Web Client.

2 Cliquez sur l'onglet .

3 Sous Stockage, cliquez sur Périphériques de stockage.

Tous les périphériques de stockage accessibles par l'hôte sont répertoriés dans le tableau Périphériques

de stockage.

4 Pour acher les détails d'un périphérique spécique, sélectionnez-le dans la liste.

22 VMware, Inc.

Page 23

Chapitre 2 Mise en route d'un modèle de stockage traditionnel

5 Utilisez les icônes pour eectuer des tâches de gestion du stockage de base.

La disponibilité d'icônes spéciques varie selon le type et la conguration du périphérique.

Icône Description

Actualiser les informations sur les adaptateurs de stockage, la topologie et les systèmes de chiers.

Réanalyser tous les adaptateurs de stockage de l'hôte pour découvrir les périphériques de stockage ou les

banques de données VMFS récemment ajoutés.

Détacher le périphérique sélectionné de l'hôte.

Aacher le périphérique sélectionné à l'hôte.

Modier le nom complet du périphérique sélectionné.

Allumer le voyant du localisateur pour les périphériques sélectionnés.

Éteindre le voyant du localisateur pour les périphériques sélectionnés.

Marquer les périphériques sélectionnés en tant que disques Flash.

Marquer les périphériques sélectionnés en tant que disques HDD.

6 Utilisez les onglets dans Détails du périphérique pour accéder à des informations supplémentaires et

modier les propriétés du périphérique sélectionné.

Onglet Description

Propriétés

Chemins

Acher les propriétés et caractéristiques du périphérique. Acher et

modier les stratégies des chemins multiples du périphérique.

Acher les chemins disponibles pour le périphérique. Désactiver ou

activer un chemin sélectionné.

Affichage des périphériques de stockage d'un adaptateur

Acher une liste des périphériques de stockage accessibles grâce à un adaptateur de stockage spécique sur

l'hôte.

Procédure

1 Accédez à l'hôte dans le navigateur de vSphere Web Client.

2 Cliquez sur l'onglet .

3 Sous Stockage, cliquez sur Adaptateurs de stockage.

Tous les adaptateurs de stockage installés sur l'hôte sont répertoriés dans le tableau Adaptateurs de

stockage.

4 Sélectionnez l'adaptateur dans la liste et cliquez sur l'onglet Périphériques.

Les périphériques de stockage auxquels l'hôte peut accéder grâce à l'adaptateur sont achés.

5 Utilisez les icônes pour eectuer des tâches de gestion du stockage de base.

La disponibilité d'icônes spéciques varie selon le type et la conguration du périphérique.

Icône Description

Actualiser les informations sur les adaptateurs de stockage, la topologie et les systèmes de chiers.

Réanalyser tous les adaptateurs de stockage de l'hôte pour découvrir les périphériques de stockage ou les

banques de données VMFS récemment ajoutés.

Détacher le périphérique sélectionné de l'hôte.

VMware, Inc. 23

Page 24

Stockage vSphere

Icône Description

Aacher le périphérique sélectionné à l'hôte.

Modier le nom complet du périphérique sélectionné.

Allumer le voyant du localisateur pour les périphériques sélectionnés.

Éteindre le voyant du localisateur pour les périphériques sélectionnés.

Marquer les périphériques sélectionnés en tant que disques Flash.

Marquer les périphériques sélectionnés en tant que disques HDD.

Marquer les périphériques sélectionnés en tant que locaux pour l'hôte.

Marquer les périphériques sélectionnés en tant que distants pour l'hôte.

Eacer les partitions sur les périphériques sélectionnés.

Comparaison des types de stockage

La prise en charge de certaines fonctionnalités de vSphere peut dépendre de la technologie de stockage que

vous utilisez.

Le tableau suivant compare les technologies de stockage en réseau pris en charge par ESXi.

Tableau 2‑2. Stockage en réseau pris en charge par ESXi

Technologie Protocoles Transferts Interface

Fibre Channel FC/SCSI Bloquer l'accès de

données/LUN

Fibre Channel sur

Ethernet

iSCSI IP/SCSI Bloquer l'accès de

NAS IP/NFS Fichier (pas d'accès direct à

FCoE/SCSI Bloquer l'accès de

données/LUN

données/LUN

LUN)

FC HBA

Adaptateur réseau convergé (FCoE

n

matériel)

Carte NIC avec prise en charge FCoE (FCoE

n

logiciel)

Carte NIC compatible iSCSI HBA ou iSCSI

n

(iSCSI matériel)

Adaptateur réseau (iSCSI logiciel)

n

Adaptateur réseau

Le tableau suivant compare les fonctions de vSphere pris en charge par diérents types de stockage.

Tableau 2‑3. Fonctions vSphere pris en charge par le stockage

API de

stockage

-

Protectio

Type de

stockage

Stockage local Oui Non VMFS Non Oui Non Oui

Fibre Channel Oui Oui VMFS Oui Oui Oui Oui

Démarrage

VM vMotion

Banque de

données RDM Cluster VM

VMware

HA et DRS

n des

données

24 VMware, Inc.

Page 25

Tableau 2‑3. Fonctions vSphere pris en charge par le stockage (suite)

Type de

stockage

iSCSI Oui Oui VMFS Oui Oui Oui Oui

NAS sur NFS Oui Oui NFS 3 et

Démarrage

VM vMotion

Banque de

données RDM Cluster VM

NFS 4.1

R Le stockage local prend en charge un cluster de machines virtuelles sur un seul hôte (connu

également sous le nom cluster dans une boîte). Un disque virtuel partagé est requis. Pour plus

d'informations sur cee conguration, consultez la documentation Gestion des ressources vSphere.

Adaptateurs de stockage pris en charge

Les adaptateurs de stockage assurent la connectivité de votre hôte ESXi à un réseau ou une unité de

stockage spécique.

ESXi prend en charge diérentes catégories d'adaptateurs, y compris SCSI, iSCSI, RAID, Fibre Channel,

Fibre Channel over Ethernet (FCoE) et Ethernet. ESXi accède directement aux adaptateurs via des pilotes de

périphériques dans le VMkernel.

Chapitre 2 Mise en route d'un modèle de stockage traditionnel

API de

stockage

-

Protectio

VMware

HA et DRS

Non Non Oui Oui

n des

données

Selon le type de stockage utilisé, vous devrez peut-être activer ou congurer un adaptateur de stockage sur

votre hôte.

Pour plus d'informations sur la conguration des adaptateurs FCoE logiciels, consultez Chapitre 6,

« Conguration de Fibre Channel over Ethernet », page 49.

Pour plus d'informations sur la conguration des diérents types d'adaptateurs iSCSI, consultez Chapitre

11, « Conguration des adaptateurs iSCSI et du stockage », page 75.

Consulter les informations sur les adaptateurs de stockage

L'hôte utilise des adaptateurs de stockage pour accéder aux diérents périphériques de stockage. Vous

pouvez acher les informations des adaptateurs de stockage disponibles et les vérier.

Prérequis

Vous devez activer certains adaptateurs, par exemple iSCSI ou FCoE, pour pouvoir acher leurs

informations. Pour congurer des adaptateurs, reportez-vous aux chapitres suivants :

Chapitre 11, « Conguration des adaptateurs iSCSI et du stockage », page 75

n

Chapitre 6, « Conguration de Fibre Channel over Ethernet », page 49

n

Procédure

1 Accédez à l'hôte dans le navigateur de vSphere Web Client.

2 Cliquez sur l'onglet .

3 Sous Stockage, cliquez sur Adaptateurs de stockage.

4 Utilisez les icônes pour eectuer des tâches liées aux adaptateurs de stockage.

La disponibilité d'icônes spéciques dépend de la conguration du stockage.

VMware, Inc. 25

Page 26

Stockage vSphere

5 Pour acher les détails d'un adaptateur spécique, sélectionnez-le dans la liste.

6 Utilisez les onglets dans Détails adaptateur pour accéder à des informations supplémentaires et

Icône Description

Ajoutez un adaptateur de stockage. S'applique aux iSCSI logiciels et aux FCoE logiciels.

Actualisez les informations sur les adaptateurs de stockage, la topologie et les systèmes de chiers de l'hôte.

Réanalyser tous les adaptateurs de stockage de l'hôte pour découvrir les périphériques de stockage ou les

banques de données VMFS récemment ajoutés.

Réanalysez l'adaptateur sélectionné pour détecter les périphériques de stockage nouvellement ajoutés.

modier les propriétés de l'adaptateur sélectionné.

Onglet Description

Propriétés Vériez les propriétés générales de l'adaptateur qui incluent généralement le nom et

le modèle de l'adaptateur, ainsi que les identiants uniques formés selon les normes

de stockage spéciques. Pour les adaptateurs iSCSI et FCoE, utilisez cet onglet pour

congurer des propriétés supplémentaires, par exemple l'authentication.

Périphériques Achez les périphériques de stockage auxquels l'adaptateur peut accéder. Utilisez

l'onglet pour eectuer des tâches de gestion de périphériques de base. Reportez-vous

à « Achage des périphériques de stockage d'un adaptateur », page 23.

Chemins Répertoriez et gérez tous les chemins que l'adaptateur utilise pour accéder aux

périphériques de stockage.

Cibles (Fibre Channel et

iSCSI)

Liaison de port réseau

(iSCSI uniquement)

Options avancées (iSCSI

uniquement)

Vériez et gérez les cibles accessibles via l'adaptateur.

Congurez la liaison de port des logiciels et adaptateurs iSCSI matériels dépendants.

Congurez les paramètres avancés d'iSCSI.

Caractéristiques des banques de données

Les banques de données sont des conteneurs logiques, analogues à des systèmes de chiers, qui masquent

les informations de chaque périphérique de stockage et fournissent un modèle uniforme pour stocker des

chiers de machine virtuelle. Vous pouvez acher toutes les banques de données disponibles pour vos

hôtes et analyser leurs propriétés.

Les banques de données sont ajoutées à vCenter Server de la façon suivante :

Vous pouvez créer une banque de données VMFS, une banque de données NFS version 3 ou 4.1, ou une

n

banque de données Virtual Volumes à l'aide de l'assistant Nouvelle banque de données. Une banque de

données vSAN est automatiquement créée lorsque vous activez vSAN.

Lorsque vous ajoutez un hôte ESXi à vCenter Server, toutes les banques de données sur l'hôte sont

n

ajoutées à vCenter Server.

Le tableau suivant fournit des informations détaillées sur les banques de données que vous pouvez acher

lorsque vous eectuez une analyse des banques de données avec vSphere Web Client. Certaines

caractéristiques peuvent ne pas être disponibles ou ne pas s'appliquer à tous les types de banques de

données.

26 VMware, Inc.

Page 27

Chapitre 2 Mise en route d'un modèle de stockage traditionnel

Tableau 2‑4. Informations sur les banque de données

Informations sur les

banque de données

Nom VMFS

Type de système de

chiers

Sauvegarde de

périphériques

Points de terminaison

de protocole

Extensions VMFS Extensions individuelles de la banque de données et

Type de lecteur VMFS Type de périphérique de stockage sous-jacent (par

Capacité VMFS

Point de montage VMFS

Ensembles de

capacités

Storage I/O Control VMFS

Type de banque de données

applicable Description

Nom modiable aecté à la banque de données. Pour

NFS

vSAN

Virtual Volumes

VMFS

NFS

vSAN

Virtual Volumes

plus d'informations sur la manière de renommer une

banque de données, consultez « Modier le nom d'une

banque de données », page 187.

Système de chiers utilisé par la banque de données.

Pour plus d'informations sur les banques de données

VMFS et NFS et sur la manière de les gérer, reportez-

vous à Chapitre 17, « Utilisation des banques de

données », page 157.

Pour obtenir des informations sur les banques de

données vSAN, reportez-vous à la documentation de

Administration de VMware vSAN.

Pour obtenir des informations sur Virtual Volumes,

reportez-vous à Chapitre 22, « Utilisation de Virtual

Volumes », page 267.

VMFS

NFS

vSAN

Informations relatives au stockage sous-jacent, comme le

périphérique de stockage sur lequel la banque de

données est déployée (VMFS), le serveur et le dossier

(NFS) ou les groupes de disques (vSAN).

Virtual Volumes Informations sur les points de terminaison du protocole

correspondant. Reportez-vous à « Points de terminaison

de protocole », page 271.

capacité correspondante.

exemple, un lecteur Flash ou disque dur ordinaire). Pour

des détails, veuillez vous reporter à la section Chapitre

15, « Utilisation des périphériques Flash », page 143.

Inclut la capacité totale, l'espace alloué et l'espace libre.

NFS

vSAN

Virtual Volumes

Chemin d'accès à la banque de données dans le

NFS

répertoire /vmfs/volumes/ de l'hôte.

vSAN

Virtual Volumes

VMFS

R Une banque de données

VMFS multi-extensions assume les

Informations sur les services de données de stockage

fournies par l'entité de stockage sous-jacente. Vous ne

pouvez pas les modier.

capacités d'une seule de ses

extensions.

NFS

vSAN

Virtual Volumes

Informations sur l'activation de la priorisation E/S du

NFS

stockage dans l'ensemble des clusters. Consultez la

documentation de Gestion des ressources vSphere.

VMware, Inc. 27

Page 28

Stockage vSphere

Tableau 2‑4. Informations sur les banque de données (suite)

Informations sur les

banque de données

Accélération

matérielle

Balises VMFS

Connectivité avec les

hôtes

Gestion multivoie VMFS

Type de banque de données

applicable Description

VMFS

NFS

vSAN

Virtual Volumes

NFS

vSAN

Virtual Volumes

VMFS

NFS

Virtual Volumes

Virtual Volumes

Informations précisant si l'entité de stockage sous-

jacente prend en charge l'accélération matérielle. L'état

peut être Pris en charge, Non pris en charge ou Inconnu.

Pour des détails, veuillez vous reporter à la section

Chapitre 24, « Accélération matérielle du stockage »,

page 309.

R NFS 4.1 ne prend pas en charge

l'accélération matérielle.

Capacités de la banque de données que vous dénissez

et associez à des banques de données sous forme de

balises. Pour plus d'informations, consultez « Aecter

des balises à des banques de données », page 239.

Hôtes sur lesquels la banque de données est montée.

Règles de sélection de chemin d'accès utilisées par l'hôte

pour accéder aux espaces de stockage. Pour plus

d'informations, consultez Chapitre 18, « Présentation de

la gestion multivoie et du basculement », page 203.

Afficher les informations relatives aux banques de données

Accéder à la vue Banques de données avec le navigateur de vSphere Web Client.

Utilisez la vue Banques de données pour répertorier toutes les banques de données disponibles dans

l'inventaire d'infrastructure vSphere, analyser les informations et modier les propriétés. Vous pouvez

également utiliser cee vue pour créer des banques de données.

Procédure

1 Utilisez l'une des méthodes suivantes pour accéder aux banques de données.

Dans le navigateur vSphere Web Client, sélectionnez Listes d'inventaires vCenter > Banques de

n

données.

Accédez à un objet qui est un objet parent valide d'une banque de données, par exemple un centre

n

de données, un cluster ou un hôte, puis cliquez sur l'onglet Banques de données.

Les banques de données disponibles dans l'inventaire gurent dans le panneau central.

2 Utilisez les icônes pour créer une banque ou eectuer des tâches basiques sur une banque de données

sélectionnée.

La disponibilité des icônes spéciques dépend du type de la banque de données et de sa conguration.

Icône Description

Enregistrer une machine virtuelle existante dans l'inventaire.

Créer une banque de données.

Augmenter la capacité de la banque de données.

Accédez à l'explorateur de chiers de la banque de données.

Gérez les fournisseurs de stockage.

28 VMware, Inc.

Page 29

Chapitre 2 Mise en route d'un modèle de stockage traditionnel

Icône Description

Monter une banque de données aachée à certains hôtes.

Supprimer une banque de données

Démonter une banque de données aachée à certains hôtes.

3 Pour acher les détails d'une banque de données spécique, cliquez sur une banque de données

sélectionnée.

4 Utilisez les onglets pour accéder à des informations supplémentaires et modier les propriétés des

banques de données.

Onglet Description

Démarrage Acher les informations élémentaires et accéder aux options de base.

Résumé Acher les statistiques et la conguration de la base de données sélectionnée.

Surveiller Acher les alarmes, les données de performance, l'allocation des ressources, les événements et

autres informations sur l'état relatives à la banque de données.

Acher et modier les propriétés de la banque de données. Les éléments de menu qui s'achent

dépendent du type de banque de données.

Autorisations Aribuer ou modier les autorisations pour la banque de données sélectionnée.

Fichiers Accédez à l'explorateur de chiers de la banque de données.

Hôtes Achez les hôtes sur lesquels la banque de données est montée.

VM Achez les machines virtuelles résidant sur la banque de données.

VMware, Inc. 29

Page 30

Stockage vSphere

30 VMware, Inc.

Page 31

Présentation de l'utilisation d' ESXi

avec un SAN 3

L'utilisation d'ESXi avec un SAN signie plus de souplesse, plus d'ecacité et plus de abilité. L'utilisation

d'ESXi avec un SAN prend également en charge la gestion centralisée et les technologies de basculement et

d'équilibrage de charge.

L'utilisation d'ESXi avec un SAN vous ore les avantages suivants :

Vous pouvez stocker vos données de manière sécurisée et congurer plusieurs chemins vers votre lieu

n

de stockage an d'éliminer tout risque de défaillance d'un point de stockage unique.

L'utilisation d'un SAN avec les systèmes ESXi prolonge la résistance aux pannes sur le serveur. Lorsque

n

vous utilisez un stockage SAN, toutes les applications peuvent être immédiatement redémarrées sur un

autre hôte suite à la panne de l'hôte d'origine.

Vous pouvez eectuer la migration en direct des machines virtuelles à l'aide de VMware vMotion.

n

Utilisez VMware High Availability (HA) avec un SAN pour redémarrer des machines virtuelles dans

n

leur dernier état connu sur un serveur diérent en cas de défaillance de leur hôte.

Utilisez VMware Fault Tolerance (FT) pour copier les machines virtuelles protégées sur deux hôtes

n

diérents. Les machines virtuelles continuent à fonctionner sans interruption sur l'hôte secondaire en

cas de défaillance de l'hôte principal.

Utilisez VMware Distributed Resource Scheduler (DRS) pour migrer les machines virtuelles depuis un

n

hôte vers un autre an d'obtenir un équilibrage de charge. Le stockage se trouvant sur une baie SAN

partagée, les applications continuent de s'exécuter de manière transparente.

Si vous utilisez des clusters VMware DRS, meez l'hôte ESXi en mode maintenance an que le système

n

migre toutes les machines virtuelles en service vers d'autres hôtes ESXi. Ensuite, vous pouvez eectuer

les mises à niveau ou d'autres opérations de maintenance sur l'hôte d'origine.

La portabilité et l'encapsulation des machines virtuelles VMware sont un complément à la nature partagée

de ce stockage. Lorsque les machines virtuelles se trouvent sur un stockage SAN, vous pouvez rapidement

arrêter une machine virtuelle sur un serveur et la démarrer sur un autre serveur, ou la suspendre sur un

serveur et reprendre l'activité sur un autre serveur sur le même réseau. Ainsi, vous pouvez migrer des

ressources informatiques tout en maintenant un accès partagé cohérent.

Ce chapitre aborde les rubriques suivantes :

« Cas d'utilisation d'ESXi et du SAN », page 32

n

« Informations détaillées sur l'utilisation du stockage SAN avec l'ESXi », page 32

n

« Hôtes ESXi et baies de stockage multiples », page 33

n

« Prendre des décisions LUN », page 33

n

« Sélection de l'emplacement des machines virtuelles », page 35

n

VMware, Inc.

31

Page 32

Stockage vSphere

« Applications de gestion tierces », page 35

n

« Considérations sur la sauvegarde de stockage SAN », page 36

n

Cas d'utilisation d' ESXi et du SAN

Lorsque l'ESXi est utilisé avec un SAN, il peut bénécier de multiples fonctionnalités vSphere, y compris

Storage vMotion, Distributed Resource Scheduler (DRS), High Availability, etc.

L'utilisation de l'ESXi avec un SAN est ecace pour les tâches suivantes :

Consolidation du

stockage et

simplification de

l'architecture de

stockage

Maintenance sans

interruption de service

Équilibrage de charge

Récupération d'urgence

Si vous travaillez avec plusieurs hôtes et que chacun d'entre eux utilise

plusieurs machines virtuelles, le stockage sur les hôtes n'est plus susant.

Vous allez devoir utiliser un stockage externe. Le SAN peut fournir une

architecture système simple et orir d'autres avantages.

Lors de la maintenance d'une infrastructure ou d'un hôte ESXi, utilisez

vMotion pour migrer les machines virtuelles vers un autre hôte. Si le

stockage partagé se trouve sur le SAN, vous pouvez eectuer les opérations

de maintenance sans aucune interruption pour les utilisateurs des machines

virtuelles. Les processus de travail de VM continuent au cours d'une

migration.

Vous pouvez ajouter un hôte à un cluster DRS et les ressources de l'hôte font

partie des ressources du cluster. La répartition et l'utilisation du CPU et des

ressources mémoire de tous les hôtes et des machines virtuelles du cluster

sont constamment surveillées. DRS compare ces mesures à une utilisation

idéale des ressources. L'utilisation idéale prend en compte les aributs des

pools de ressources du cluster et des machines virtuelles, la demande

actuelle et la cible de déséquilibre. Si besoin est, DRS eectue ou

recommande des migrations de machine virtuelle.

Vous pouvez utiliser VMware High Availability pour congurer plusieurs

hôtes ESXi comme un cluster. Le cluster ore une récupération rapide à la

suite de pannes et une haute disponibilité à moindre coût pour les

applications s'exécutant dans les machines virtuelles.

Migrations de baies et

mises à niveau du

stockage simplifiées

Lorsque vous achetez de nouveaux systèmes de stockage, utilisez Storage

vMotion pour eectuer des migrations en direct des machines virtuelles d'un

stockage existant vers leurs nouvelles destinations. Vous pouvez eectuer les

migrations sans aucune interruption des machines virtuelles.

Informations détaillées sur l'utilisation du stockage SAN avec l' ESXi

L'utilisation d'un SAN avec un hôte ESXi dière de l'utilisation classique d'un SAN de diérentes manières.

Lorsque vous utilisez le stockage SAN avec l'ESXi, les considérations suivantes s'appliquent :

Vous ne pouvez pas utiliser les outils d'administration du SAN pour accéder aux systèmes

n

d'exploitation des machines virtuelles qui résident sur le stockage. Avec les outils traditionnels, vous

pouvez uniquement surveiller le système d'exploitation VMwareESXi. Pour surveiller les machines

virtuelles, vous devez utiliser vSphere Web Client.

Le HBA visible aux outils d'administration du SAN fait partie du système ESXi et non de la machine

n

virtuelle.

En règle générale, votre système ESXi eectue la gestion multivoie pour vous.

n

32 VMware, Inc.

Page 33

Hôtes ESXi et baies de stockage multiples

Un hôte ESXi peut accéder aux périphériques de stockage présentés depuis plusieurs baies de stockage, y

compris des baies provenant de diérents fournisseurs.

Si vous utilisez plusieurs baies provenant de diérents fournisseurs, les considérations suivantes

s'appliquent :

Si votre hôte utilise le même SATP pour plusieurs baies, soyez prudent lorsque vous modiez le PSP

n

par défaut pour ce SATP. La modication s'applique à toutes les baies. Pour plus d'informations sur les

SATP et PSP, consultez Chapitre 18, « Présentation de la gestion multivoie et du basculement »,

page 203.

Certaines baies de stockage formulent des recommandations sur la profondeur de la le d'aente et

n

d'autres paramètres. En général, ces paramètres sont congurés de manière globale au niveau de l'hôte

ESXi. La modication des paramètres d'une baie aura des répercussions sur les autres baies qui

présenteront les LUN à l'hôte. Pour plus d'informations sur la modication de profondeur de la le

d'aente, consultez l'article de la base de connaissances VMware sur hp://kb.vmware.com/kb/1267.

Utilisez le zonage à initiateur et cible uniques lors du zonage d'hôtes ESXi vers des baies Fibre Channel.

n

Avec ce type de conguration, les événements liés à une infrastructure qui se produisent sur une baie

n'ont pas de répercussions sur les autres baies. Pour plus d'informations sur le zonage, consultez

« Utilisation du zonage avec les SAN Fibre Channel », page 41.

Chapitre 3 Présentation de l'utilisation d' ESXi avec un SAN

Prendre des décisions LUN

Vous devez planier la conguration du stockage de vos systèmes ESXi avant de formater les LUN avec les

banques de données VMFS.

Lorsque vous prenez une décision LUN, les considérations suivantes s'appliquent :

Chaque LUN doit avoir le bon niveau RAID et des caractéristiques de stockage correctes pour les

n

applications s'exécutant dans les machines virtuelles utilisant le LUN.

Chaque LUN ne doit contenir qu'une banque de données VMFS.

n

Si plusieurs machines virtuelles ont accès au même VMFS, utilisez les partages de disque pour classer

n

les machines virtuelles par ordre de priorité.

Vous pourriez souhaiter utiliser moins de LUN mais de plus grande taille pour les raisons suivantes :

Plus de souplesse de création des machines virtuelles sans avoir à demander plus d'espace de stockage

n

à l'administrateur.

Plus de souplesse de redimensionnement des disques virtuels, de prise de snapshots et de bien d'autres

n

choses encore.

Moins de banques de données VMFS à gérer.

n

Vous pourriez souhaiter utiliser moins de LUN et de plus petite taille pour les raisons suivantes :

Gain d'espace.

n

Diérentes applications pourraient nécessiter des caractéristiques RAID diérentes.

n

Plus de souplesse grâce à la dénition de la règle de gestion multivoie et des partages de disque par

n

LUN.

L'utilisation du service de cluster de Microsoft (Microsoft Cluster Service) exige que chaque ressource

n

de disque en cluster soit dans sa LUN respective.

Meilleures performances car un volume unique subit moins de contention.

n

VMware, Inc. 33

Page 34

Stockage vSphere

Lorsque les caractéristiques de stockage d'une machine virtuelle ne sont pas disponibles, il peut s'avérer

dicile de déterminer le nombre et la taille des LUN à provisionner. Vous pouvez essayer d'utiliser un

schéma prédictif ou adaptatif.

Utilisation du schéma prédictif pour prendre les décisions de LUN

Lors de la dénition du stockage pour les systèmes ESXi, et avant la création de banques de données VMFS,

vous devez décider de la taille et du nombre de LUN à mere en place. Vous pouvez essayer le schéma

prédictif.

Procédure

1 Meez en place plusieurs LUN avec diérentes caractéristiques de stockage.

2 Créez une banque de données VMFS sur chaque LUN, en étiquetant chaque banque de données selon

ses caractéristiques.

3 Créez des disques virtuels qui contiendront les données des applications de la machine virtuelle dans

les banques de données VMFS créées sur les LUN avec le niveau RAID approprié aux conditions

requises des applications.

4 Utilisez les partages de disque pour distinguer les machines virtuelles disposant des priorités les plus

hautes de celles ayant les priorités les plus basses.

R Les parts de disque sont uniquement utiles au sein d'un hôte déni. Les parts assignées

aux machines virtuelles sur un hôte n'exercent aucun eet sur des machines virtuelles sur d'autres

hôtes.

5 Exécutez les applications pour déterminer si les performances de la machine virtuelle sont acceptables.

Utilisation du schéma adaptatif pour prendre les décisions de LUN

Lors de la dénition du stockage pour les hôtes ESXi, avant la création de banques de données VMFS, vous

devez décider de la taille et du nombre de LUN à mere en place. Vous pouvez essayer le schéma adaptatif.

Procédure

1 Meez en place une LUN (RAID 1+0 ou RAID 5) de grande taille et activez la mise en cache des

écritures.

2 Créez un VMFS sur cee LUN.

3 Créez quatre ou cinq disques virtuels sur le VMFS.

4 Exécutez les applications pour déterminer si les performances du disque sont acceptables.

Si les performances sont acceptables, placez les disques virtuels supplémentaires sur le VMFS. Si les

performances ne sont pas acceptables, créez un nouveau LUN de grande taille avec un niveau RAID

diérent et répétez la procédure. Utilisez la migration an de ne pas perdre les données des machines

virtuelles lorsque vous recréez la LUN.

34 VMware, Inc.

Page 35

Chapitre 3 Présentation de l'utilisation d' ESXi avec un SAN

Sélection de l'emplacement des machines virtuelles

Si vous souhaitez optimiser les performances de vos machines virtuelles, l'emplacement du stockage est un

facteur important. Selon vos besoins de stockage, vous pouvez sélectionner un stockage avec des

performances élevées et une haute disponibilité ou un stockage avec des performances inférieures.

Le stockage peut être divisé en plusieurs niveaux, selon un certain nombre de facteurs :

Niveau élevé. Ore de hautes performances et une grande disponibilité. Peut orir des snapshots

n

intégrés pour faciliter les sauvegardes et les restaurations instantanées. Prend en charge la réplication,

la redondance complète des processeurs de stockage et les lecteurs SAS. Utilise des axes de prix élevé.

Niveau intermédiaire Ore des performances de milieu de gamme, une disponibilité plus faible,

n

quelques redondances de processeurs de stockage et des lecteurs SCSI ou SAS. Peut fournir des

snapshots. Utilise des axes de prix moyen.

Niveau inférieur Ore des performances faibles, peu de redondance de stockage interne. Utilise des

n

lecteurs SCSI bas de gamme ou SATA.

Les machines virtuelles ne doivent pas toutes se trouver sur le stockage possédant les meilleures

performances et la plus grande disponibilité tout au long de leur cycle de vie.

Lors du choix de l'emplacement d'une machine virtuelle, les considérations suivantes s'appliquent :

Criticité de la machine virtuelle

n

Exigences en matière de performances et de disponibilité

n

Exigences en matière de restauration instantanée

n

Exigences en matière de sauvegarde et de réplication

n

Une machine virtuelle peut changer de niveau tout au long de son cycle de vie en raison de modications de

la criticité ou de la technologie. Son importance est relative et peut changer pour diverses raisons, parmi

lesquelles les modications apportées à l'organisation, les processus opérationnels, les obligations

réglementaires, la planication suite à un incident, etc.

Applications de gestion tierces

Vous pouvez utiliser les applications de gestion tierces avec votre hôte ESXi.

La majorité des matériels SAN sont délivrés avec le logiciel de gestion du stockage. Dans la majorité des cas,

ce logiciel est une application Web qui peut être utilisée avec tout navigateur Web connecté à votre réseau.

Dans certains autres cas, ce logiciel s'exécute habituellement sur le système de stockage ou sur un serveur

unique, indépendamment des serveurs utilisant le SAN pour le stockage.

Utilisez le logiciel de gestion tiers pour eectuer les tâches suivantes :

La gestion des baies de stockage, y compris la création de LUN, la gestion de la mémoire cache des

n

baies, le mappage de LUN et la sécurité des LUN.

La conguration de la réplication, des points de vérication, des snapshots ou de la mise en miroir.

n

Si vous exécutez le logiciel de gestion du SAN sur une machine virtuelle, vous bénéciez de tous les

avantages d'une machine virtuelle, y compris le basculement à l'aide de vMotion et de VMware HA.

Toutefois, en raison du niveau supplémentaire d'indirection, il se peut que le logiciel de gestion ne soit pas

en mesure de voir le SAN. Dans ce cas, utilisez un RDM.

R Le succès d'exécution d'un logiciel de gestion par une machine virtuelle dépend du système de

stockage.

VMware, Inc. 35

Page 36

Stockage vSphere

Considérations sur la sauvegarde de stockage SAN

Une stratégie de sauvegarde appropriée est l'un des aspects les plus importants de la gestion d'un SAN.

Dans un environnement SAN, les sauvegardes ont deux objectifs. Le premier objectif est d'archiver des

données en ligne sur des supports hors ligne. Ce processus est répété régulièrement pour toutes les données

en ligne, selon un calendrier. Le second objectif est de fournir un accès aux données hors ligne pour une

restauration en cas de problème. Par exemple, la récupération de bases de donnée nécessite souvent la

récupération des chiers de journalisation archivés qui ne sont pas en ligne à ce moment.

La programmation d'une sauvegarde dépend de plusieurs facteurs :

L'identication des applications critiques nécessitant des cycles de sauvegarde plus rapprochés dans

n

une période donnée.

Les points de restauration et les objectifs de période restaurée. Dénissez la précision nécessaire de vos

n

points de récupération et la durée d'aente souhaitée.

Le taux de changement (RoC) associé aux données. Par exemple, si vous utilisez une réplication

n

synchrone/asynchrone, le RoC aecte la quantité de bande passante requise entre les périphériques de

stockage primaires et secondaires.

L'impact global sur un environnement SAN, les performances de stockage et les autres applications.

n

L'identication des horaires de pointe sur le SAN. Les sauvegardes prévues pendant ces heures de

n

pointe peuvent ralentir les applications et le processus de sauvegarde.

Le temps passé à programmer toutes les sauvegardes dans le centre de données.

n